Nos últimos anos, estamos presenciando um rápido crescimento e popularização da ciência de dados ao redor do mundo. Na Neurotech, desenvolvemos soluções avançadas de inteligência artificial e analíticas há quase 20 anos e, entre erros e acertos, adquirimos bastante experiência sobre o tema.

Fazer ciência de dados envolve o desenvolvimento de uma solução dividida em etapas centradas na informação e na tomada de decisões, possivelmente envolvendo técnicas de machine learning, estatística e outros campos do conhecimento. Em um projeto usando machine learning, após as fases de entendimento do problema, levantamento de requisitos, tratamento dos dados, modelagem e avaliação, vem uma etapa pouco mencionada nos cursos e tutoriais: a disponibilização de modelos “em produção”.

Implantar um modelo em produção significa disponibilizá-lo

em um ambiente capaz de receber solicitações

e responder de acordo com requisitos pré-estabelecidos.

Existem vários fatores a se considerar no momento de colocar um modelo em produção e um deles é o formato de disponibilização. O formato escolhido pode impactar diretamente no tempo de resposta e na disponibilidade do modelo em produção. De modo geral, podemos dividir em duas formas como um modelo pode entrar em produção: modelos fechados e modelos interoperáveis. A seguir discorremos sobre essas abordagens, suas vantagens e desvantagens e como as utilizamos ao longo da história da Neurotech.

Um modelo fechado é aquele que você treina, salva e carrega usando a mesma linguagem de programação e/ou sistema operacional.

Até a primeira década deste século, as poucas empresas que faziam uso de machine learning para resolver problemas utilizavam esse formato. A Neurotech, por exemplo, em 2006, desenvolveu uma solução com dois sistemas usando Delphi, denominados NeuroDEV e NeuroServer, que eram utilizados, respectivamente, para criar o modelo e disponibilizá-lo em produção. Os modelos construídos por essa solução eram baseados em uma rede neural com poucos neurônios divididos em duas camadas escondidas. Justamente por essa simplificação arquitetural, o tempo de resposta era baixíssimo e os modelos em produção raramente apresentavam problemas.

Com a necessidade crescente de construirmos modelos

utilizando grandes bases de dados, essa solução começou

a apresentar problemas de escalabilidade.

Nele, por exemplo, não era possível treinar

uma base com mais de 1 milhão de registros

e algumas centenas de variáveis.

Diante desse cenário e da popularização da ciência de dados, bem como o surgimento de vários frameworks de machine learning, foi preciso darmos um passo à frente. Foi nesse contexto que surgiu o Prophet, um framework desenvolvido na Neurotech com versões em Spark e python, que tem como objetivo abstrair muito dos detalhes envolvidos na criação de um modelo usando machine learning, além de facilitar a implantação do modelo em produção.Nossa primeira aposta para salvar o modelo treinado foi uma abordagem fechada usando a mesma linguagem de programação. Como uma das linguagens de programação do Prophet é python, o modo mais simples de serializar e salvar um modelo é utilizando o módulo pickle. No entanto, por ser executado em python, o tempo de execução para um modelo no formato pickle pode ser bastante elevado.

Em nossos testes, um modelo usando pickle (com etapas de tratamento de missing, outliers, codificação e predição com XGBoost) demorava um pouco mais de 1 segundo para retornar um score de um indivíduo com 200 variáveis. Na Neurotech possuímos alguns SLAs (Service Level Agreement) de tempo de resposta bem rígidos (abaixo de 200 ms) que nos impedem de usar um modelo salvo nesse formato. Diante dessa dificuldade, escolhemos utilizar abordagens interoperáveis para implantarmos os modelos criados usando o Prophet.

Um modelo caracterizado como interoperável é aquele que pode ser desenvolvido utilizando uma determinada linguagem/sistema operacional/framework e ser executado por qualquer linguagem/sistema operacional/framework.

Normalmente, os modelos construídos usando essa abordagem são traduzidos para uma metalinguagem de acordo com uma especificação. Esse metamodelo pode ser lido por um interpretador e executado em diferentes ambientes/sistemas.

Existem várias abordagens interoperáveis na literatura e em sua grande maioria possuem dois componentes: desenvolvimento e runtime (do inglês “em tempo de execução” — figura abaixo). O componente de desenvolvimento é utilizado para converter o pipeline de machine learning para um metamodelo, enquanto o runtime é o componente capaz de ler o metamodelo e utilizá-lo em produção. O que liga os componentes e permite a interoperabilidade entre as diferentes linguagens de programação é uma especificação padrão.A seguir iremos descrever duas abordagens de modelos interoperáveis que são utilizadas no Prophet: PMML e ONNX.

O PMML (Predictive Model Markup Language) é uma abordagem baseada em XML para salvar um modelo de machine learning e é mantido pelo Data Mining Group. A versão atual é a 4.4, disponibilizada em 2019. O PMML nada mais é que um arquivo XML contendo todas as regras do pipeline do modelo. Cada algoritmo dentro do pipeline possui um parser que transforma a lógica do algoritmo para XML.A simplicidade no entendimento do código em XML para modelos pequenos é a principal vantagem do PMML, pois pode ser facilmente entendido e editável. Por outro lado, para grandes modelos, que geram PMMLs com milhares linhas de código XML, entender o fluxo pode ser uma tarefa bastante laboriosa. A principal dificuldade que encontramos nesse padrão é a complexidade na implementação de novos parsers para XML.

O Prophet utiliza o projeto JPMML como base para criar os modelos em PMML. Esse projeto contém parsers para os principais algoritmos de machine learning em Spark e sklearn. No entanto, para muito dos algoritmos do Prophet, é necessário desenvolver parsers customizados. Dependendo da complexidade do algoritmo, construir um parser para PMML pode demorar vários dias. Além disso, como o projeto JPMML é mantido por apenas um usuário, a criação de novos parsers é lenta.

Em termos de execução em produção, o PMML atende bem às

expectativas. Um modelo em PMML responde em média

por volta de 20 ms para um registro com 200 variáveis.

Outro ponto importante a se destacar é que nunca tivemos problemas de estabilidade ou disponibilidade em produção utilizando PMML.

O ONNX (Open Neural Network Exchange), assim como o PMML, permite a interoperabilidade dos componentes de desenvolvimento e runtime. Esse padrão foi criado em 2017 com o apoio da Microsoft e Facebook. Como o nome sugere, o ONNX surgiu primeiramente para suprir a necessidade de interoperabilizar os vários frameworks de redes neurais que surgiram nos últimos anos, como PyTorch, TensorFlow e Caffe. Com o passar do tempo, ele acabou abrangendo algoritmos fora do universo de redes neurais. Hoje é possível encontrar suporte para algoritmos de predição do estado da arte como XGBoost, lightGBM e CatBoost.

O ONNX funciona como um grafo, onde cada nó do grafo representa um estágio do treinamento e é chamado de operador. Dessa forma, deve existir um operador para cada algoritmo do pipeline do modelo.

A capacidade de reutilização desses operadores é sem dúvida a grande grande vantagem do ONNX. Existem operadores dos mais simples (soma, subtração, média, etc.) até os mais complexos (árvore de decisão, SVM, regressão linear, entre outros). Essa variedade nos permite criar novos operadores e combiná-los de diferentes formas. Quanto ao tempo de processamento, o ONNX responde em de aproximadamente 10 ms para um registro com 200 variáveis.

A desvantagem do ONNX está no pouco suporte às variáveis categóricas. Como o Prophet é um framework focado em dados estruturados que podem ter muitas variáveis categóricas, tivemos que desenvolver operadores para o tratamento dessas variáveis em um nível mais baixo. Dessa forma, criamos a nossa própria versão do ONNX com novos operadores categóricos nas duas pontas, desenvolvimento e runtime.

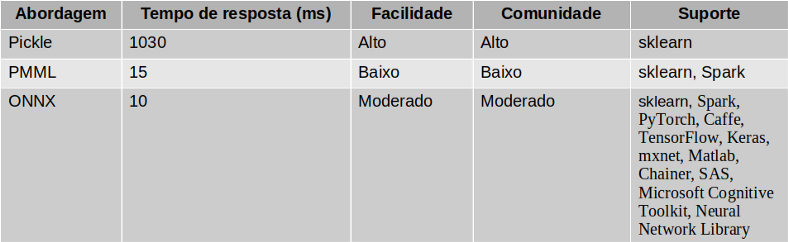

Abaixo apresentamos nossa avaliação das abordagens listadas nesse artigo. As abordagens foram avaliadas considerando o tempo de resposta, facilidade, comunidade e suporte. O tempo de resposta foi medido usando um modelo de classificação binária com algoritmos de tratamento de missing, outliers, codificação e XGBoost. A facilidade diz respeito ao quão fácil é utilizar a abordagem. A comunidade mensura o grau de atividade dos usuários da comunidade. Quanto maior e ativa for a comunidade, mais rápidas são as atualizações. Por fim, em suporte são listados os frameworks que dão suporte às abordagens.

Comparação entre pickle, PMML e ONNX.Hoje na Neurotech, nosso serviço que suporta o deploy dos modelos em produção, chamado de Alfred, consegue utilizar tanto o PMML quanto ONNX de forma rápida, escalável e robusta.

Esperamos que esta breve revisão tenha sido útil aos interessados em ferramentas para disponibilizar modelos em produção. Acreditamos no poder dos dados e da inteligência artificial para abrir oportunidades e mitigar riscos com eficiência e, justamente por isso, necessitamos de modelos em produção rápidos e robustos. Se você quer entrar nesse mundo de ciência dos dados, estamos no tempo mais propício, vá em frente.

Wendeson Silva, Reniê A. Delgado e Guilherme Boaviagem Ribeiro são engenheiros de Machine Learning e cientistas de dados na Plataforma Neurolake | Neurotech

Sabemos que trabalhar de casa pode ser algo novo para alguns de vocês, talvez até desnorteante enquanto nos ajustamos a este novo ambiente. Um dos nossos objetivos é permitir que você trabalhe de casa com a maior segurança possível. Abaixo há cinco medidas simples para trabalhar com segurança. A melhor parte é que todas essas medidas não só ajudam a proteger seu trabalho como também deixarão você e sua família mais protegidos, em um lar ciberneticamente seguro.

1. Você: Antes de mais nada, é importante saber que a tecnologia por si só não é capaz de protegê-lo totalmente. Você é a melhor defesa. Os atacantes já aprenderam que a melhor forma de conseguir o que querem é tendo você como alvo, em vez de seu computador ou outros dispositivos. Se quiserem sua senha, seus dados de trabalho ou controle do seu computador, eles tentarão enganar você e induzi-lo a dar isso a eles, muitas vezes criando um senso de urgência. Por exemplo, eles podem telefonar fingindo ser o suporte técnico da Microsoft e alegar que seu computador está infectado. Ou podem enviar um e-mail avisando que não foi possível entregar uma encomenda, lhe enganando e fazendo com que clique em um link malicioso. Os indicadores comuns de um ataque de engenharia social incluem:

2. Rede Doméstica: Quase toda rede doméstica inclui uma rede sem fio (também chamada de WiFi). É ela que permite que todos os seus dispositivos se conectem com a internet. A maioria das redes domésticas sem fio é controlada pelo roteador de internet ou um ponto de acesso sem fio dedicado, separado. Ambos funcionam da mesma maneira: transmitindo sinais sem fio que os dispositivos domésticos usam para se conectar. Isso significa que proteger sua rede sem fio é uma parte fundamental para proteger a sua casa. Para isso, nós recomendamos as seguintes medidas:

Não sabe como seguir esses passos? Peça ajuda ao seu provedor de internet, verifique o site deles, confira a documentação que veio com o ponto de acesso sem fio, consulte o site do fornecedor ou converse com a equipe de segurança da informação da Neurotech.

3. Senhas: Quando um site pedir para você criar uma senha, crie uma senha forte. Quanto mais caracteres ela tiver, melhor. Usar uma frase secreta é uma das formas mais simples de garantir uma senha forte. Uma frase secreta não passa de uma senha composta por várias palavras, como “abelha mel uísque”. Usar uma frase secreta única significa criar diferentes frases para cada dispositivo ou conta online. Assim, se uma frase secreta for comprometida, todos os seus outros dispositivos e contas estarão seguros.

Não consegue se lembrar de todas as frases secretas?!Use um gerenciador de senhas, um programa especializado que armazena todas as suas frases secretas com segurança em um formato criptografado (e também inclui vários outros recursos excelentes!).

Por fim, sempre que possível, habilite a verificação em duas etapas (também chamada de autenticação de fator duplo ou multifator). Além de usar sua senha, esse recurso adiciona uma segunda etapa, como um código enviado para o seu smartphone ou gerado por um aplicativo. A verificação em duas etapas é provavelmente a medida mais importante que você pode adotar para proteger suas contas online, e é muito mais simples do que talvez você esteja pensando.

GERENCIADOR DE SENHAS:

VERIFICAÇÃO EM DUAS ETAPAS:

4. Atualizações: Certifique-se de que todos os seus computadores, dispositivos móveis, programas e aplicativos estejam com a versão mais recente do software. Atacantes cibernéticos estão sempre em busca de novas vulnerabilidades nos softwares dos seus dispositivos. Quando descobrem vulnerabilidades, eles usam programas especiais para se aproveitar disso e invadir os seus dispositivos. Enquanto isso, as empresas que criaram os softwares nesses dispositivos trabalham duro para consertá-los, lançando atualizações.

Assegurando que os seus computadores e dispositivos móveis instalem essas atualizações prontamente, você dificulta bastante o trabalho dos invasores. Para se manter atualizado, simplesmente habilite as atualizações automáticas sempre que possível. Essa regra se aplica a quase toda tecnologia conectada a uma rede, incluindo não só seus dispositivos de trabalho, mas também outros aparelhos que se conectam com a internet, como TVs, monitores de bebê, câmeras de segurança, roteadores, videogames, e até mesmo seu carro.

5. Crianças e convidados: Algo que provavelmente não é uma preocupação no escritório são crianças, convidados ou outros membros da família querendo usar seu laptop ou outros dispositivos de trabalho. Certifique-se que sua família e seus amigos entendam que não podem usar seus dispositivos de trabalho. Sem querer, eles podem acabar apagando ou modificando informações, ou até pior, infectando o dispositivo.

Fonte: sans.org

Há quem diga que mudanças profundas anteriormente previstas para acontecer somente daqui a cinco anos se tornarão realidade em menos de 12 meses. Outra aposta é que a participação das vendas online no varejo brasileiro vai triplicar rapidamente antecipando uma movimentação prevista para se consolidar somente em quatro ou cinco anos. A construção dos modelos de machine learning e Inteligência Artificial, que até aqui consumia semanas ou meses, precisará ser acelerada para que as entregas ocorram em, no máximo, sete dias.

A pandemia do Covid-19 modificou totalmente o cenário no varejo brasileiro e vai exigir rápida adaptação com soluções que não serão usadas apenas durante a crise. Elas virão para ficar.

Estes e outros temas foram discutidos com grande profundidade durante o primeiro Web Encontro da Neurotech que teve como pergunta central: “Que novas soluções podemos criar para superar a crise no varejo?”

A discussão contou com a participação do sócio e diretor de Novos Negócios da Neurotech, Rodrigo Cunha, do Diretor Comercial da Conductor, Edrei Costa, da fundadora da Fort Brasil, Juliana Freitas, e do diretor comercial da Neurotech, Breno Costa.

Acompanhe o bate papo na íntegra:

Com um montante superior a 60 milhões de residências, o Brasil atualmente possui uma cobertura de seguros que protege apenas algo próximo de 14% dessas habitações. Na Europa e nos Estados Unidos, por exemplo, além das diversidades culturais, bem como, por terem enfrentado períodos dramáticos como guerras, terremotos e furacões, estas regiões desenvolveram um maior senso de necessidade de proteger seu patrimônio. Neste sentido, o isolamento social causado pela pandemia do Covid-19 é um evento que nunca enfrentamos antes na história recente, capaz de despertar nos brasileiros um nível de atenção parecido.

O Superintendente de Produtos Massificados da HDI Seguros, Jefferson Silvestrin, afirma que ao permanecerem mais tempo em suas casas, as pessoas automaticamente começarão a perceber a importância de assegurar que toda a estrutura de funcionamento do local esteja em plena forma. “Não adianta você estar seguro na sua residência se a sua casa ou apartamento também não estiver seguro. Uma caixa d´água suja ou um problema na instalação elétrica, por exemplo, podem trazer transtornos ou doenças nesse momento particularmente difícil”, diz.

De acordo com ele, tradicionalmente, o mercado segurador tem feito uma abordagem que privilegia a proteção no caso da ocorrência de grandes eventos como incêndios, para convencer o consumidor, mas isto tem feito com que a grande maioria não entenda o seguro residencial como uma necessidade imediata.

Neste sentido, o home office durante o cenário atual de isolamento já está contribuindo para mostrar a relevância de ter um suporte das seguradoras para assuntos considerados corriqueiros. A necessidade de interação e resolução de problemas de maneira remota, por exemplo, já tem mudado a forma como os consumidores têm interagido com as seguradoras.

Tradicionalmente, o seguro residencial tem como serviços mais requisitados a instalação e retirada de caçambas para entulhos, limpeza de caixas d´água, revisões elétricas, desentupimentos de tubulações hidráulicas e consertos de eletrodomésticos, mas os especialistas alertam para o fato de que sempre haverá possibilidades de incrementos nas coberturas.

A opinião é compartilhada por Daniel Gusson, gerente da área de seguros da Neurotech. Ele chama a atenção para algumas possibilidades onde a tecnologia pode ajudar, como a substituição de vistorias presenciais dos imóveis feitas por engenheiros e técnicos, pelo envio de fotos por meio de programas especializados. “A análise de dados e de hábitos do consumidor tem promovido também uma transformação no mercado de seguros. Tendo como base o CEP de uma residência, por exemplo, a inteligência artificial pode ajudar a desenvolver planos personalizados, mais aderentes às necessidades das residências de cada região“, diz.

Segundo ele, com a atenção despertada para os cuidados com seus imóveis e serviços adaptados às necessidades corriqueiras do seu dia-a-dia, o brasileiro vai gradualmente passando a viver uma nova relação com o seguro residencial. A situação que o mundo passa já mudou a interação da sociedade com as empresas. Não sabemos até quando a pandemia perdurará e o mercado deve ficar atento às novas formas de relação e necessidades dos consumidores, durante e pós-crise.

Leia mais sobre Seguros:

INTELIGÊNCIA ARTIFICIAL APLICADA AO SETOR DE SEGUROS

IA NO MERCADO DE SEGUROS

O alcance que a tecnologia da informação e o Big Data têm dentro de uma organização é muito maior do que você pensa. Sabia que alguns dos setores revolucionados por essas estratégias são os de gestão administrativa, planejamento e atendimento ao cliente? O responsável por isso é o Business Analytics. É por meio dele que você pode garantir, entre tantas outras coisas, que a sua empresa tenha uma gestão de riscos eficaz. Como isso acontece? Continue com a gente!

De forma simplificada, Business Analytics é o processo de coleta, cruzamento, organização, análise, compartilhamento e manutenção de dados e informações para a tomada de decisões a partir do conhecimento extraído. Todos esses dados já existem dentro da sua empresa.

O que acontece é que essa organização e análise sistemática os transforma em insights mais acessíveis e estratégicos, para que a gestão, os colaboradores e os clientes possam identificar problemas, descobrir padrões e prever oportunidades de decisões que trazem mais resultados ou benefícios.

Em relação à gestão de risco, o Business Analytics usa essa organização e cruzamento de dados para avaliar a operação e prever, problemas futuros e as consequências das decisões antes delas serem tomadas. Essas previsões podem ser usadas em inúmeras situações: ao decidir se determinado cliente está apto a receber algum crédito, ao investir em ações na bolsa de valores e a identificar quais clientes estão prestes a trocar a empresa pelo concorrente.

Além dessa grande vantagem, outras também são trazidas pelo Business Analytics.

Viu só como a análise de dados vai muito além do conhecido uso no marketing de uma empresa? Com o Business Analytics você usa todo o conhecimento a seu favor: entende como analisar cada dado adquirido e os usa para estruturar a sua empresa de forma adequada.

Você ou o seu negócio enfrenta algum desafio no ciclo de relacionamento com o seu cliente?

Nós podemos ajudar. Temos auxiliado nossos clientes a otimizar recursos e potencializar resultados no varejo, em bancos, financeiras e em seguros.

Faça um diagnóstico gratuito agora!Estes três termos – Inteligência Artificial, Machine Learning e Deep Learning – estão cada vez mais presentes em aplicações do nosso dia a dia. Cada um deles é, a seu modo, uma ferramenta ou tecnologia que permite a uma máquina reproduzir habilidades similares às dos seres humanos – e até superiores, em alguns casos.

Antes de começar a explicar as tecnologias, vamos falar do combustível para elas funcionarem: a informação!

Hoje, mais de 5 bilhões de pessoas no mundo utilizam o celular para acessar e postar textos, fotos e vídeos diariamente. São trilhões de dados sobre suas vidas, interações nas redes sociais, compras, transações, o carro que utilizam, os programas que gostam de assistir, os amigos que possuem, a localização física e muitas outras informações.

Essa quantidade infindável de dados forma uma rede de informação jamais vista que chamamos de Big Data.

Vamos ao segundo ponto para explicar as diferenças entre a Inteligência Artificial, o Machine Learning e o Deep Learning: a modelagem de dados.

A modelagem é essencial na hora de classificar, processar e analisar as informações de uma forma que o computador consiga entender e trabalhar a informação, sendo responsável por capturar a lógica do problema, sua funcionalidade e seu comportamento.

As inúmeras informações do Big Data ficam “perdidas” sem uma modelagem de dados consistente, não podendo ser utilizadas para extrair conhecimento.

Se no início a lógica da modelagem era bastante básica, hoje algoritmos complexos auxiliam na criação de novas soluções cada vez mais disruptivas para facilitar nossas vidas.

Essa modelagem é realizada não com programas tradicionais nos quais definimos como a máquina deve agir para cada entrada, mas sim com algoritmos que aprendem a resolver os problemas.

E como ensinamos as máquinas? Por meio de exemplos, usados como referências, que podem vir de bases de dados de fraudes, compras, interações com call centers, seguros contratados ou de imagens, vídeos, registros de voz, dados de dispositivos, textos em documentos e que representam situações do dia-a-dia.

Inteligência Artificial é o termo amplo usado para abranger todas as máquinas, ferramentas, métodos e dispositivos que realizam atividades inteligentes, como o próprio nome já indica. Isso significa que tudo aquilo que é dotado de IA tem a capacidade de raciocinar, solucionar problemas, planejar, manipular objetos ou reconhecer vozes, rostos e imagens.

A inteligência artificial é uma subárea da ciência da computação direcionada ao desenvolvimento de computadores que são capazes de atuar em situações que costumeiramente são realizadas por pessoas.

Ou, de maneira mais geral, capazes de resolver problemas complexos, nos quais hoje a melhor referência de solução é a humana.

As máquinas executam funções cognitivas — associadas ao aprendizado humano e ao raciocínio para decidir — por meio de algoritmos inovadores, simulando a nossa forma de assimilar informações, generalizar sobre casos passados e tomar decisões em situações futuras.

O computador deixa de ser um mero coadjuvante que só recebe ordens para ganhar o poder de fazer suas próprias escolhas. Os exemplos são inúmeros em diversas áreas e já estão bastante presentes na nossa rotina.

Podemos citar os processos de concessão de crédito de uma financeira, a previsão de sinistros de uma seguradora, os aspiradores de pó que se movem sem auxílio humano pela casa, os sistemas de auxílio a diagnóstico médico, o reconhecimento facial usado no desbloqueio de alguns smartphones e o atendimento virtual feito por assistentes que encontramos em lojas e bancos.

Para que você possa entender as diferenças entre a IA e os outros dois conceitos que explicaremos a seguir, é preciso visualizar o Machine Learning e o Deep Learning como os dois pilares que constroem o conceito de Inteligência Artificial. Eles são, portanto, os responsáveis pela popularização da IA.

Como dissemos, os dados são o combustível para a Inteligência Artificial funcionar. Vamos falar agora do motor dessa máquina: o Machine Learning. Ele é capaz de correlacionar um volume imenso de informações para extrair conhecimento e tomar decisões.

Não é necessário programar o computador para procurar por informações específicas, ele aprende de maneira “autodidata”. Isso significa que em vez de programar normas do tipo “se-então”, os desenvolvedores apresentam exemplos de situações passadas e informam o que aquela informação representa.

Pode ser a ocorrência de uma fraude, uma tentativa de invasão a um sistema, uma compra realizada ou uma imagem. A partir da alimentação de um número de casos, o computador “descobre” as características dos casos e generaliza para fornecer respostas corretas em situações futuras.

A Aprendizagem da Máquina, em tradução livre, é o ato de usar algoritmos, técnicas, dados e procedimentos para programar uma máquina através de aprendizagem, a partir de exemplos, tornando-a apta a resolver problemas.

Assim, ela é capaz de identificar padrões, realizar atividades repetitivas, aprender com erros, prever comportamentos e, finalmente, ser usada para tomar decisões.

Os resultados do uso dessa tecnologia do aprendizado de máquina são mais do que satisfatórios.

Os principais deles são a diminuição de erros humanos nos processos, a capacidade de analisar informações em um volume impossível para os seres humanos, o ganho de escala no processamento e a velocidade em produção.

Se ao compreender o conceito de Machine Learning você deduziu que essa é uma ferramenta nova no mercado, está enganado. Hoje, a gigantesca quantidade de dados disponíveis e a evolução tecnológica permitiram que algoritmos muito mais complexos e rápidos fossem desenvolvidos.

A consequência disso foi elevar a Aprendizagem da Máquina a um novo patamar: o Deep Learning.

O Deep learning é uma subárea do Machine Learning. São métodos evoluídos das redes neurais, que explodiram nos últimos anos. As redes neurais se inspiram no cérebro humano e suas propriedades, como a capacidade de aprender e generalizar.

No Deep Learning, as redes neurais artificiais são mais sofisticadas, de tamanho muito maior e com habilidade superior de extrair e representar informações.

Antes, a análise de imagens, de vídeos, o reconhecimento de voz e o processamento de textos eram muito inferiores à capacidade humana. Hoje, os resultados são surpreendentes.

No modo tradicional, há necessidade de um especialista para definir as características para representar imagens, antes de treinar a máquina, por exemplo. É trabalhoso porque é preciso levar em conta que objetos podem estar em posições e cenários diferentes, precisam ser isolados do fundo etc.

Com os modelos Deep Learning, a definição das características relevantes e a extração delas é feita pela própria máquina. Um número grande de imagens é necessário para capturar as características. Isso mesmo: a máquina é capaz de descobrir e definir as características frequentes nos exemplos.

E com um detalhe a mais: o reaproveitamento de fases iniciais da máquina para o reconhecimento de outros tipos de imagens. Antes, para cada aplicação, era preciso uma máquina diferente.

Agora, o reuso de parte da máquina em algumas diferentes aplicações é possível. Isso é o caminho mais próximo para a criação de máquinas mais gerais para várias aplicações. Com essas propriedades, o Deep Learning não só elevou a precisão das máquinas a outro patamar, como ampliou muito o número de aplicações.

Como usar Inteligência Artificial, Machine Learning e Deep Learning a seu favor?

Como podemos ver, Inteligência Artificial, o Machine Learning e o Deep Learning são parte de um todo, no qual uma engloba a outra. E qual o benefício disso tudo?

Quando uma empresa conta com esse tipo de tecnologia integrada e bem configurada, além de se destacar no seu nicho de atuação, garante otimização em processos internos e externos, melhora a experiência do cliente, reduz riscos e falhas humanas. E, naturalmente, capta e conquista mais clientes.

Ficou interessado sobre como o Big Data pode fazer a diferença na gestão de riscos da sua empresa? Fale com a gente e saiba mais sobre os nossos serviços.

A Neurotech é referência em transformar um mundo de dados dispersos em informações confiáveis e relevantes para que nossos clientes prevejam novas oportunidades de negócios e obtenham resultados expressivos.

Faça aqui um diagnóstico e veja como podemos lhe apoiar em seus desafios de negócio.

Nos últimos meses, começamos a nos perguntar na Neurotech se toda a expertise em I.A e Big Data que utilizamos há 19 anos para bancos, financeiras e seguradoras também poderia ser utilizada com um objetivo diferente: ajudar nossa carteira de clientes a vender mais através de modelos preditivos para o marketing.

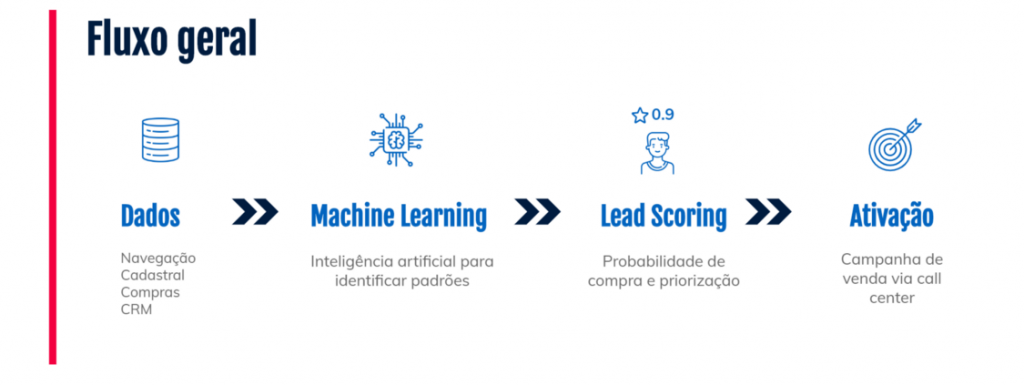

Como podemos gerar mais conversão em vendas para e-commerces? Como priorizar visitantes mais propensos a compras em websites? Como prever consumidores que irão dar churn? Como identificar personas que podem ser top compradoras de uma base? Foi com esses questionamentos que criamos uma iniciativa de Digital Analytics e ajudamos um e-commerce com problemas de baixa conversão em vendas.

Com mais de 2,5 milhões de usuários cadastrados em seu e-commerce, o cliente nos procurou com o desafio de identificar quais desses usuários deveriam ser priorizados para prospecção via campanhas de call center ativo. A empresa possui em torno de 30 colaboradores dedicados à realização de milhares de ligações telefônicas semanalmente.

Apesar de oferecer produtos com alto valor agregado, a maior parte dos usuários consomem apenas produtos free (ebooks, infoprodutos, etc) e não convertem em vendas reais. Esse tipo de cenário é bastante comum em e-commerces onde a concorrência é muito grande.

Como o cliente já possuía uma base relevante de consumidores cadastrados na plataforma e que estavam prontos para serem trabalhados, nosso time pensou em criar um modelo de propensão a compras na base de já cadastrados do cliente com o objetivo de priorizar quais usuários possuiam maior chance de compras no website.

Portanto, em vez de se preocupar em atrair novos usuários para o e-commerce, e assim, gastar dinheiro com campanhas de marketing, adotamos a estratégia de buscar na base de já cadastrados aqueles que possuiam melhores chances de compras para serem abordados.

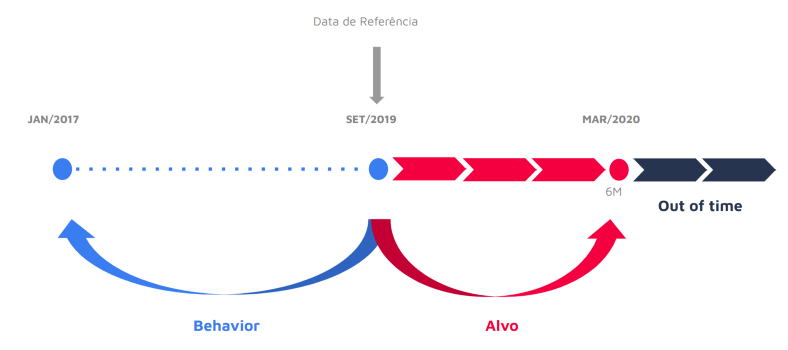

Antes da construção de qualquer modelo de Inteligência Artificial, realizamos um estudo analítico chamado de backtesting, que é a simulação de um modelo preditivo usando dados históricos. Estudar o passado para prever o futuro.

A partir de informações cadastrais, histórico de compras e o comportamento navegacional de cada usuário dentro do e-commerce, foi possível montar uma visão de dados e realizar o primeiro experimento. É importante frisar que, os dados utilizados neste estudo de caso estão em compliant com as regras de proteção de dados regidos pela LGDP.

Tendo como base a data de referência em Set/2019, entendemos todo o histórico dos consumidores desde Jan/2017 e projetamos o alvo de compra para 6 meses à frente, em Mar/2020. Esse tipo de análise é importante para saber quem são os compradores (ou não) contido nos dados em determinado período.

Na fase de criação do modelo preditivo, selecionamos uma amostra de 425 mil usuários e dividimos em dois conjuntos: 75% da base para treinamento, ou seja, achar os padrões de comportamento nos dados e os 25% restantes para teste do modelo treinado.

A partir do modelo desenvolvido, escoramos toda a base de usuários cadastrados do cliente para saber quais deles possuiam uma maior "probabilidade" de compra nos próximos 6 meses. O Score de Propensão varia de 0 a 100, quanto maior o score do usuário, maiores as chances de compras.

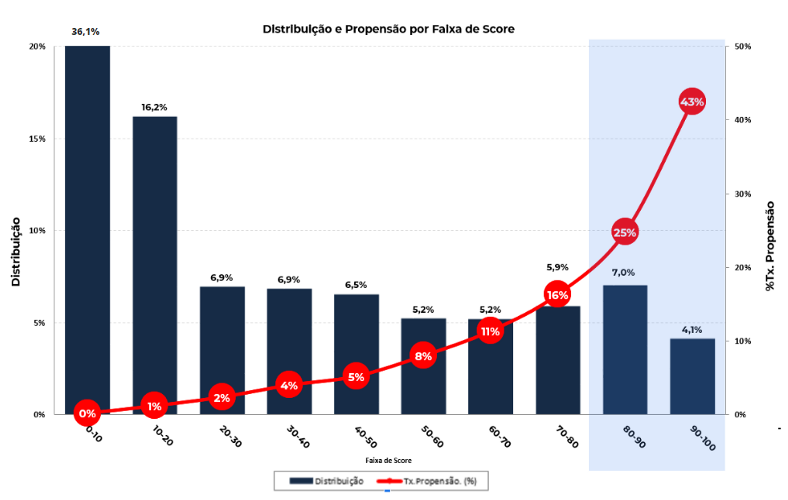

Como pode ser visto na imagem abaixo, geralmente criamos um gráfico de distribuição de scores para visualizar o comportamento do modelo criado. Para isso, distribuímos os usuários scorados em faixas de 10 em 10 e cruzamos com a Taxa de conversão, que é a chance de conversão daquele usuário dentro daquela faixa de score. Observe que nas faixas de score de 80 a 100, as chances de conversão são bem maiores e variam entre 25% a 43%, bem acima da taxa de conversão média de 6,6% informada pelo cliente.

Olhando apenas esse gráfico, foi possível visualizar que o modelo treinado separou bem a população dos possíveis compradores daqueles que estão apenas dormentes na base.

Observe que, em apenas 11,1% da base, é possível quase quadruplicar (4x) as chances de vendas neste e-commerce.

Como os consumidores das faixas de score acima de 80 detinham maior chance de realizarem compras no e-commerce, separamos todos esses usuários que atendiam ao critério de possuirem telefone preenchido nos dados. Ao todo, foram mais de 19 mil usuários priorizados e enviados para o cliente prospectar via call center ativo.

Ao receber os leads quentes, o cliente criou um teste A/B com duas campanhas de vendas via call center: a primeira com os leads recebidos do modelo de propensão a compras e a segunda com uma lista de leads comumente utilizada pela empresa através de técnicas de marketing. Vale salientar que foram utilizados os mesmos tipos de ofertas e abordagens ao prospectar os consumidores em ambas as campanhas.

Após algumas semanas, recebemos os resultados de conversão coletados pelo cliente. Ficamos bastante animados ao saber que a nossa lista alcançou uma conversão 32% superior (Lift) e um ticket médio 2X maior para cada compra realizada.

Neste momento, estamos em processo de implantação em produção do modelo criado na operação do cliente. Precisamos automatizar toda a parte de acesso aos dados dos usuários recebidos e entregar inteligência via modelos de machine learning em tempo hábil de prospecção.

Vale salientar que, os dados que mais contribuíram para o bom desempenho do modelo foram os dados de comportamento digital dos usuários dentro do e-commerce. Esse tipo de informação de behavior possui uma grande relevância quando falamos de propensão a compras e a tecnologia utilizada na coleta desses dados de forma anonimizada será assunto de um próximo post.

Assim como todas as demais áreas da economia, a tendência do volume de concessões de crédito é de clara desaceleração. Mas, ainda assim, o mecanismo pode e deve ser uma das mais importantes ferramentas do arsenal econômico para amenizar os efeitos da pandemia do coronavírus no PIB brasileiro. A projeção para 2020 dada pelo relatório Focus de 13 de março, recuou para 1,68%. Há quatro semanas, o incremento esperado era de 2,23%. A tendência é que as perspectivas para o PIB recuem ainda mais nas próximas semanas. O Credit Suisse, por exemplo, cortou a sua estimativa de crescimento para zero.

Com a abrupta queda da demanda, empresas precisarão de fôlego para sobreviverem à crise e, portanto, será a postura das instituições financeiras brasileiras, tanto das grandes e tradicionais como das recém-chegadas fintechs, o divisor de águas entre a quebra de pequenas e médias ou sua sobrevivência. Tais estabelecimentos, geralmente familiares, não têm estrutura para aguentar semanas ou meses com demanda reduzida ou quase zero, como é o caso de bares e restaurantes. Isso não quer dizer, entretanto, que tenham problemas financeiros estruturais, mas sim que precisam de caixa para fechar as contas durante este período.

No caso das pessoas físicas, a necessidade de aumento na concessão de crédito pessoal será sentida no médio-prazo, pois a redução da renda e aumento do desemprego não são efeitos tão imediatos como a queda do capital de giro das PMEs. Mesmo assim, é preciso lembrar que o endividamento das famílias já era um problema pré-crise e que o cartão de crédito e o cheque especial, respondem por 80% do total. Não é de se descartar, portanto, um aumento na inadimplência, pois estas duas linhas exibem taxas de juros elevadas.

Felizmente, a postura das instituições financeiras demonstra que o momento é de consciência social, ou seja, não deve ocorrer um forte enxugamento da oferta de crédito. Um exemplo disso é que as cinco principais instituições associadas à Federação Brasileira dos Bancos (Febraban) - Banco do Brasil, Bradesco, Caixa Econômica Federal, Itaú Unibanco e Santander aderiram à prorrogação de dívidas por 60 dias para pessoas físicas, micro e pequenas empresas, com exceção das linhas de cartão de crédito e o cheque especial.

Para pessoas físicas, a prorrogação abrange linhas de empréstimo pessoal, de crédito imobiliário e aquisição de veículos. Para as pequenas empresas, a medida será destinada apenas para financiamento de capital de giro, linha utilizada pelos empreendedores para garantir o fluxo de caixa.

Além disso, ainda este mês entrou em vigor as alterações nas regras dos depósitos compulsórios. Segundo a estimativa do Bacen, as medidas têm potencial de injetar R$ 135 bilhões no mercado, porém isso dependerá das instituições financeiras. Mas ainda assim é preciso avançar e aí é que as fintechs poderão desempenhar um papel importante.

Embora ainda limitadas por uma capacidade de funding reduzida, baseada fortemente em FIDCs, essas startups financeiras têm utilizado tecnologias inovadoras e modelos de negócios mais flexíveis que as tornam capazes de levar a concessão de crédito de uma forma mais abrangente e democrática não só às PMEs, mas também a pessoas com histórico de crédito inexistente ou com maior dificuldade de comprovação.

Segundo pesquisa realizada pelo Sebrae em parceria com a Associação Brasileira de Fintechs, a ABFintechs, na metade das fintechs brasileiras pelo menos 30% dos clientes são formados por pequenos negócios, sendo que em 40% dos casos as MPE são maioria na carteira de clientes. Apenas 10% da fintechs não atende pessoas jurídicas e 84,1% delas demonstraram interesse em desenvolver produtos e serviços específicos às necessidades das micro e pequenas empresas.

Dados de mercado dão conta que, até o mês passado, cerca de 90% das empresas de pequeno porte tinham capital de giro para seu dia a dia, mas não um colchão de liquidez para se proteger.

Deve-se lembrar que o Brasil ainda não conseguiu se recuperar completamente da última crise. Entre 2015 e 2016, o PIB recuou 7,5% e de lá para cá, o crescimento anual ficou ao redor do 1%. Mas isso não quer dizer que o mesmo ocorrerá daqui para frente. A recessão destes anos foi estrutural. O que ocorre agora é uma crise pontual que vem de fora. Nestes casos, a retomada tende a ser bem mais rápida.

Para acalmar o mercado, a autoridade monetária destacou que ainda conta com mais balas na agulha para que as concessões de crédito continuem a apoiar a retomada da economia e assegurar a estabilidade financeira. Fora isso, toda a ajuda será bem-vinda. O momento é de incerteza, mas sem dúvida de união, criatividade e consciência social.

LEIA TAMBÉM:

O varejo já é e continuará sendo um dos setores mais afetados pela pandemia do COVID-19. Até a crise chegar, as projeções eram de que este segmento registraria um incremento de 5% nas vendas em comparação ao ano passado. Apesar de o mês de fevereiro ainda ter sido positivo, com o faturamento em alta de 5,2% descontada a inflação, segundo o Índice Cielo do Varejo Ampliado (ICVA), em março a tendência é de reversão. De acordo com o ICVA, na primeira semana deste mês houve uma queda de 3,8% no faturamento das varejistas e na segunda de 6%.

Além da própria queda das vendas, outros fatores impactam o segmento como um todo. As principais envolvem a demanda incerta, a mudança nos hábitos de consumo e a possibilidade de crise de abastecimento. Com relação ao comércio eletrônico, há um paradoxo sobre o comportamento das vendas.

Por um lado, o isolamento recomendado pela Organização Mundial da Saúde (OMS) leva as pessoas a evitarem aglomerações para realizarem suas compras seja em shoppings ou supermercados. Segundo dados recentes da consultoria Technomic, no mundo, 52% dos consumidores evitam multidões e 32% saem de casa com menos frequência por causa do coronavírus. Tal demanda reprimida acaba sendo compensada pelo comércio online. O maior varejista online da China, JD.com, por exemplo, viu as vendas de produtos básicos comuns quadruplicarem nas últimas semanas quando comparadas ao mesmo período do ano passado.

Por outro lado, a recessão que ameaça a frágil economia brasileira leva à redução da confiança do consumidor que deve voltar suas compras para bens essenciais. Ao mesmo tempo, há a ameaça de crise de abastecimento em alguns produtos, principalmente daqueles que são importados da China ou dependem de matéria-prima daquele país. Assim, não é possível afirmar categoricamente que o e-commerce viverá os seus dias de glória nos próximos meses.

Para reduzir os impactos negativos da crise provocada pelo COVID-19, algumas medidas devem ser tomadas e os empresários podem utilizar a tecnologia a seu favor. A primeira é fazer uma análise criteriosa da mudança do perfil do consumidor. Através dos dados disponíveis sobre como as pessoas navegam no site, é possível obter alguns insights. Isso é possível através do aperfeiçoamento dos robôs.

Os algoritmos são capazes de analisar como ocorrem as navegações dentro da página para entender como os usuários se comportam e que caminhos buscam fazendo a comparação deste momento de crise em relação aos períodos anteriores sem a crise. Cerca de 5 mil variáveis, que vão da forma como a pessoa manuseia o mouse à velocidade da digitação, são analisadas para que se encontre padrões de comportamentos.

Assim, o empresário consegue prever a demanda e se antecipar a ela. Essas informações são essenciais para o aprimoramento da gestão das experiências com o consumidor, o que é essencial para uma crise como a atual. É extremamente importante tratar o cliente exatamente como ele está se sentido neste momento, onde prevalece a insegurança. A expectativa é de que as empresas e as experiências de compras e atendimentos sejam um alívio em tempos difíceis.

Ao mesmo tempo, com uma gestão da experiência do cliente mais próxima, as empresas decidem com mais precisão se vão comprar ou não determinado produto e qual produto ofertar. Através do cruzamento de milhares de variáveis, identifica-se produtos mais consumidos hoje e que nos próximos meses deixarão de ser adquiridos por conta de mudança de comportamentos, como o álcool gel, por exemplo.

A crise no varejo é inevitável, porém, algumas medidas podem ser tomadas para amenizá-la. O importante é a empresa estar preparada para antecipar os movimentos de mudança da demanda e ser transparente com o consumidor, sempre buscando aprimorar a sua experiência. Quem tomar a frente e usar a tecnologia a seu favor, não só sobreviverá à crise, mas sairá mais fortalecido dela.

Depois de tantos anos de Neurotech, esta semana será a primeira da nossa história em que faremos home office para a grande maioria das pessoas. Resolvi escrever um pouco das minhas estratégias e experiências pessoais no home office para ajudar as pessoas a serem produtivas trabalhando em casa. O relato abaixo não é uma sugestão do que fazer, mas sim um relato como eu estou lidando com a situação, que pode servir de referência para você e/ou sua equipe. Também quero aprender! Então fiquem à vontade para comentar e contar sobre as suas estratégias.

Primeiro, e mais importante de tudo, eu tento sempre manter a rotina. Ontem mesmo acordei às 6h como de costume e fui fazer exercício (em casa mesmo). Adaptei a academia/corrida para dentro de casa (não é a mesma coisa, mas deu para suar). “Voltei para casa” e acordei meus filhos, como faço todos os dias. Fiz o café de todos (aqui mudei somente a ordem, porque o café normalmente eu faço antes do exercício). Depois do café, tomei banho e me arrumei para ir ao trabalho. Isso mesmo! Parece loucura, mas mandar a mensagem para o cérebro que vou trabalhar é importante.

Nesse caso, eu coloquei uma bermuda e chinelo kkkkkkk, e não uma calça e tênis como de costume, e fiquei pronto para o dia de trabalho. Chamei o quarto do meu computador de “Quarto Neurotech”. Quando meus filhos me perguntam para onde eu estou indo, respondo: “Para Neurotech” kkkkkk. Eles riem e já sabem que agora tem um “Quarto da Neurotech”. Luana, minha caçula de 9 anos, até fez um cartaz para dizer que eu estou trabalhando. Fica na porta para todos saberem que estou trabalhando: "Aqui está trabalhando um DataNinja"

Quando fui sentar na frente do computador, já “entrando na Neurotech”, tive um imprevisto. Minha filha pediu para tomar o leite. Bom, pelo menos foi mais rápido fazer o leite do que pegar um Uber e passar 40min em deslocamento.

Depois do leite, sentei na frente do computador e fiz o planejamento do dia. Uso o Google Tasks para organizar o to-do e o Trello para ver o sprint da semana. Já o time da Plataforma Neurolake utiliza o Jira para controle dos sprints. Entro lá também todos os dias para ver como está a cadência do time. Por ora, tudo funcionando. Melhor do que eu esperava!

No Slack já tinha mensagens dos vários canais que participo. Em vários momentos, precisei falar com as pessoas. Primeiro mandei mensagens pelo Slack, mas, sempre que houve dúvida, eu liguei (seja pelo Hangout, ou seja, pelo celular). Nessas horas, interagir por voz faz diferença

Foi engraçado que, em várias ligações, escutamos as vozes das crianças. Não é massa? Trabalhar e estar próximo da família. Fizemos até um vídeo para mostrar quem são as crianças kkkkk.

Depois de várias reuniões e ligações, o dia terminou com um sentimento de produtividade. Não perdi 1 hora e 20 em deslocamento e usei esse tempo para 1) dar um cochilo entre 13h e 13h30 e 2) lavar os pratos no final do dia e ajudar nas tarefas de casa (cada um tem feito sua parte).E ainda deu para prestar atenção em algumas que só ficando em casa para perceber:

Depois de várias reuniões e ligações, o dia terminou com um sentimento de produtividade. Não perdi 1 hora e 20 em deslocamento e usei esse tempo para 1) dar um cochilo entre 13h e 13h30 e 2) lavar os pratos no final do dia e ajudar nas tarefas de casa (cada um tem feito sua parte).

E, além da saúde (claro), todo mundo está preocupado com os negócios. Ou seja, estamos buscando manter as agendas comerciais e de atendimento mesmo remotamente, porque é do interesse de todos não deixar a peteca cair.

Tenho dúvidas de quando isso irá terminar, mas tenho 3 certezas:

Vamos para cima (Não do Corona! hehehehehe)!

A ativação de clientes ganhou destaque quando o marketing digital popularizou o termo. Entenda o valor do processo e como otimizá-lo.

O consumidor moderno não quer apenas manter relações transacionais de compra e venda com as empresas e nem define mais suas escolhas com base em critérios objetivos, como o menor preço e qualidade do produto.

Desta forma, uma experiência ruim pode não só impedir a efetivação de uma venda, como matar o próprio negócio. Não à toa, a ativação de clientes ganhou destaque nos últimos tempos, quando o marketing digital popularizou o termo.

Mas será que todos sabem qual o real valor desse processo? E como otimizá-lo frente às inovações tecnológicas?

A ativação do cliente é uma estratégia de Marketing que tem como objetivo despertar o desejo de consumo, facilitando o processo natural da jornada do consumidor. É uma prática que pode ser implementada em qualquer fase da jornada, desde o lead até a conversão.

Está claro que do primeiro contato dependerá a relação estabelecida com o produto ou marca. Se o relacionamento for de confiança, ótimo. Se for confuso, porém, pode criar barreiras e abrir brechas para aproximar a concorrência.

Isso porque o mínimo que se espera é que a empresa apresente soluções para seus possíveis problemas na hora em que o consumidor precisa.

Além, é claro, de se certificar que por trás desse contato está uma corporação que desenvolve ações centradas nas questões humanas e socioambientais.

Assim, torna-se essencial mapear a jornada de consumo para prever e identificar padrões que revelam o momento de decisão de compra de cada potencial cliente, bem como seu perfil.

Isto é, a hora certa e o melhor canal para fazer uma oferta. Algo possível graças à evolução das soluções de Inteligência Artificial, que trouxeram, dentre tantos benefícios, ferramentas para ativação do cliente.

Com Big Data e Inteligência Artificial, por exemplo, as empresas são capazes de apoiar todas as fases do ciclo de relacionamento, otimizando recursos e potencializando resultados.

A análise de agrupamentos (cluster), técnica estatística que agrupa dados semelhantes automaticamente, permite identificar os consumidores que têm maior aderência a um produto ou serviço.

O que torna possível combinar uma série de informações e personalizar a abordagem e o atendimento a determinados perfis.

Um sinal disso é a diferença que a Inteligência Artificial faz para as empresas nesse relacionamento com seus consumidores.

Ao apontar tendências e estratégias baseadas nos comportamentos pessoais de cada um deles, melhora suas experiências e reduz custos, graças à capacidade de atender o consumidor de forma única e com uma experiência memorável.

No cenário corporativo atual é fundamental entender o conceito e a importância do Business Analytics, não só pensando na sustentabilidade do negócio, mas principalmente, em novas oportunidades. Os serviços vêm mudando drasticamente com a transformação digital e serão centrados, cada vez mais, no consumidor.

Estudo recente da Accenture & Oxford Economics com 90 executivos evidencia, para os próximos 5 anos, uma migração de investimentos em infraestrutura e eficiência operacional para aplicações focadas na experiência do cliente. E para isso o Business Analytics será, cada vez mais, peça chave no processo.

De maneira simplista, pode-se considerar que o Business Analytics é um instrumento que converte dados do negócio em conhecimento. Trata-se de um campo abrangente que se utiliza de técnicas matemáticas, estatísticas, modelagem preditiva e aprendizagem de máquina (do inglês, machine learning) para encontrar padrões e conhecimento significativo em dados. E encontrar padrões é fundamental para entender as necessidades individuais do consumidor e tratá-lo de forma personalizada.

A ideia é colocar os dados no centro do processo de decisão com capacidades avançadas de inteligência de negócios, para prever ofertas estratégicas de produtos e serviços. Estima-se que esse mercado alcance a cifra de US$ 27 bilhões já em 2020. Novas aplicações e avanços tecnológicos surgem a cada momento e abrem inúmeras portas para o Business Analytics.

Pesquisa da EMC mostra que em 2020 o volume de informações chegará a 40 mil exabytes, o equivalente a 40 trilhões de gigabytes. Para se ter ideia do que isso representa, com apenas 1 gigabyte dá para assistir 5 horas de vídeos no YouTube, ouvir 160 músicas no Spotify ou enviar 10 mil mensagens de e-mails. É muito dado que se tratado de forma adequada se transforma em informação valiosa.

Já é repetido como um mantra que os dados são a nova riqueza do mundo. Mas, afinal, o quanto eles podem ser úteis e como lidar com eles?

Tudo depende, é claro, das necessidades. Aplicações envolvem desde a simples checagem de dados para garantir a veracidade de informações até análises mais sofisticadas para prever resultados de decisões em diferentes cenários. Podemos dividir as análises em descritivas, diagnósticas, preditivas e prescritivas.

A análise descritiva ajuda os gestores a interpretar informações históricas sobre os dados. Em uma cadeia de lojas no varejo, por exemplo, ela permite entender que faixa etária comprou mais, que produtos, em que região, que volumes, com que frequência, em que momento na safra.

A análise diagnóstica procura explicar porque algo ocorreu. Nessa análise, correlações nos dados podem descobrir o perfil dos produtos de sucesso ou fracasso no exemplo acima.

Na análise preditiva, se quer prever o que ocorrerá no futuro a partir de uma decisão tomada. É antecipar o resultado da decisão. Estimar o risco de alguém não pagar uma compra a crédito é um exemplo. Prever a chance de um veículo ser roubado com meses de antecedência é outro.

E, finalmente, na análise prescritiva, sugere-se ações para os gestores a partir da previsão dos resultados. Por exemplo, estimando que um cliente terá dificuldade de honrar o pagamento de um empréstimo, pode-se recomendar outro tipo de produto de crédito mais adequado ao seu perfil.

São análises decisivas para a gestão porque conseguem ampliar a visão de negócios ao entregar insights para departamentos fundamentais da organização. Assim, ajudam não apenas a aumentar a rentabilidade e eficiência operacional da empresa, mas principalmente, a prestar um serviço de melhor qualidade ao consumidor e à sociedade.

Em resumo, o Business Analytics é uma ferramenta veloz, flexível e de amplo alcance, com aplicação em diversos serviços, onde hajam dados a serem analisados; e capaz de atender as mais diversas indústrias, cada vez mais cobradas pela governança de seus dados.

É preciso levar em conta que há uma economia da informação em curso e que a inteligência de dados é fundamental na estratégia de qualquer negócio. Não é necessário adotar uma postura radical de transformar o negócio da noite para o dia, mas essa tendência só aumentará nos próximos anos. Também não é exagero dizer que o Business Analytics já está influindo na competitividade das empresas, ao menos para aquelas que já perceberam sua importância e adotaram uma postura de vanguarda. Quem sair na frente vai entender o imenso potencial que o Business Analytics possui para alavancar negócios.

As instituições financeiras foram levadas a redimensionar suas operações e repensar sua relação com os clientes, com a concorrência e com o próprio dinheiro em função das inovações trazidas pela tecnologia. Milhares de terabytes de dados são transacionados diariamente e é impossível ficar de fora da interação digital pelos múltiplos canais de acesso, de segurança e de atendimento. Tocamos apenas ainda na ponta do iceberg nas possibilidades de uso de tecnologias como redes neurais, machine learning e deep learning para análise preditiva. É só o começo.

Conheça as principais tecnologias que estão transformando o mercado financeiro!

Quando se fala de transformação digital, o Big Data Analytics, por exemplo, não é mais novidade e está entre as primeiras plataformas necessárias para análise de dados em massa para tomada de decisões com precisão e agilidade. Seus benefícios estão mais do que comprovados no processo de concessão de crédito, principalmente se conciliado com recursos de Inteligência Artificial.

É importante reforçar, porém, que essa tecnologia já ajuda também as áreas de investimento na formação de carteiras diversificadas e com maior potencial de rentabilidade. Outro uso conhecido é no auxílio às formulações das políticas de juros e na análise do perfil de cada cliente, permitindo a oferta de produtos exclusivos.

O Big Data juntamente com a Inteligência Artificial são tecnologias capazes de criar ferramentas de atendimento ao consumidor muito mais interativas do que se possa imaginar. Assim, em vez de investir vultosos recursos na contratação de empresas terceirizadas especializadas em SAC, bancos e financeiras devem implementar canais digitais eficientes de comunicação com seus correntistas. Esses canais contam com robôs inteligentes que respondem a questões de alto grau de complexidade de forma natural e são capazes de alterar suas respostas à medida que aprendem com as perguntas.

E o atendimento fará toda a diferença quando o open banking, ou sistema bancário aberto, começar a vigorar. Trata-se de uma plataforma que permite a integração das chamadas interface de programação de aplicativos (API, na sigla em inglês). Parece complicado, mas o conceito é mais simples: permitir com que o cliente possa usufruir de serviços de empresas e aplicativos de terceiros conectados diretamente à plataforma do seu banco, por exemplo. No final, o cliente passa a ser dono dos seus dados e pode permitir que aplicativos tenham acesso a eles, oferecendo outros serviços de seu interesse. Na prática, todo o mercado precisa padronizar a tecnologia para facilitar a comunicação entre as instituições.

Com a abertura do leque de opções para o consumidor abrem-se também incontáveis oportunidades e desafios para todos os elos da cadeia. No caso das empresas financeiras, destaca-se, por exemplo, o desenvolvimento de novas aplicações aumentando o número de canais a ofertar seus produtos e criação de novas linhas de receita.

As transações financeiras também serão cada vez mais afetadas com o pagamento instantâneo. Isso pela transferência de valores em tempo real, seja entre pessoas físicas, para empresas ou até mesmo para órgãos públicos com disponibilidade de 24 horas por dia, 7 dias por semana. Ou seja, o beneficiário terá acesso ao valor imediatamente, mesmo em caso de pagamentos ou transferência nos fins de semana, feriados ou fora do horário bancário, ao contrário do que acontece com os TEDs e DOCs, por exemplo.

Outra tecnologia já bastante conhecida que completa essa transformação é a Blockchain. Seu projeto original tem servido de inspiração para o surgimento das criptomoedas (a mais conhecida, Bitcoin) e de bancos de dados distribuídos. Por meio dela, os dados das transações deixam de ser armazenados em um único local para serem distribuídos e validados por diversos pontos de uma rede. Hoje, muitos bancos usam esse sistema de autenticação para reduzir custos com segurança, ampliar a proteção na transmissão de dados e melhorar sua eficiência operacional.

A Biometria é outra que vem para transformar o mercado ao mitigar riscos e combater fraudes. Envolve reconhecimento manuscrito, facial e da íris nos chamados ATMs. Na Europa já há testes de monitoramento realizado dentro das próprias empresas, que cruzam montanhas de dados relacionados ao andar de cada cliente para validar sua identidade. Com isso, é possível identificar, em questão de segundos, se o indivíduo é quem diz ser.

Ao longo de 2019, mostramos várias histórias que demonstravam o poder de transformação dos negócios com o uso da Inteligência Artificial. Com ela os gestores conseguem definir estratégias inovadoras, automatizar processos, monitorar o mercado e os concorrentes, conquistar e fidelizar clientes, prever hábitos de consumo, entre tantas outras possibilidades.

Como a inteligência artificial tem a capacidade de aprender o comportamento humano, ela é uma fonte sem limites para o universo corporativo e vem impactando diretamente os resultados das empresas. Estamos em um período em que toda organização, seja ela de pequeno, médio ou grande porte precisa avaliar as diretrizes para atuar em 2020, e uma forma eficiente de se fazer isso é através dos dados!

De acordo com a pesquisa divulgada em outubro último pela Forrester, 53% dos tomadores de decisão globais de dados e análises, afirmaram que adotaram, estão em processo de adoção ou expandindo o uso de soluções baseadas em IA.

Em 2019, 29% dos desenvolvedores globais trabalharam com software de IA e de aprendizado de máquina (Machine Learning). E o uso de IA deve aumentar, pois segundo a pesquisa, 16% dos tomadores de decisão globais de marketing B2C pretendem aumentar em mais de 10% o gasto com tecnologia de dados e análise, incluindo IA, em 2020.

Não faltam soluções baseadas em IA para aplicar e melhorar o desempenho de uma empresa. Claro que cada aplicação é desenvolvida para solucionar uma demanda do negócio e a tecnologia entra para identificar melhores oportunidades, aproximar o cliente, reduzir riscos, diminuir fraudes, automatizar processos, otimizar cobranças, precificar de forma mais eficiente e etc.

Seja qual for a área de atuação, há muitas possibilidades para explorar a inteligência artificial.

.1. Melhorar o relacionamento com o cliente

No relacionamento com o cliente a IA facilita a comunicação, antecipa demandas e soluciona problemas. Isso porque a sua aplicação resulta em triagem mais eficiente de solicitações, reduzindo a carga operacional dos atendentes que passam a se dedicar apenas às questões que necessitam intervenção humana.

A vantagem de utilizar a tecnologia neste processo é que ela pode diminuir o tempo de atendimento dos clientes. Um exemplo de como isso se dá é de uma empresa de varejo que implementou uma solução para dar mais agilidade na avaliação do consumidor que solicitava um cartão de crédito da empresa. Com a inteligência artificial o tempo de retorno caiu de 25 para menos de 3 minutos. A satisfação do cliente abre portas para geração de novos negócios.

2. Reduzir riscos

A IA pode contribuir para reduzir riscos em diversos segmentos como Seguros e Crédito. Isso porque com o enriquecimento dos dados a solução consegue gerar insights mais seguros para os tomadores de decisão.

Em um dos casos de sucesso, uma plataforma integrada para aferição de risco identificou 17% de potenciais sinistros em apenas 5% das propostas de uma seguradora. O resultado conquistado foi equivalente a 500% de ROI, 20% na diminuição de sinistros e 5% na redução do custo anual de TI. Certamente é uma boa aposta para investimento em 2020.

3. Prever demandas

Controlar o estoque ou desenvolver um produto de acordo com a preferência do consumidor deixam de ser problemas com a Inteligência Artificial. Isso porque suas aplicações analisam as variáveis possíveis, não somente preço, mas também renda e tipos de bens demandados. Com essa informação a empresa consegue entender quanto de sua produção será consumida e por quem. Ela também permite identificar onde está o público que não conhece seus produtos.

Com a modelagem dos dados feita a partir da IA, chega-se a informações estratégicas que levam ao controle de estoque e entendimento de que tipo de produto o cliente pretende comprar e em qual quantidade. Além de proporcionar conhecimento amplo do cliente, o varejo também é mais assertivo no desenho de campanhas e no controle eficiente de estoque.

4. Prevenir e detectar fraudes

Quando as instituições financeiras alimentam os algoritmos com grandes volumes de dados, eles conseguem capturar as características que identificam os perfis dos clientes e das próprias transações. As características são guardadas na máquina, permitindo que ela preveja fraudes em transações futuras pelo padrão de comportamento.

E faz isso analisando perfis com padrões diferentes dos usuais. Por exemplo, se um cliente está fazendo muitas compras em um intervalo de tempo menor e em diferentes lugares, consequentemente, é possível que não seja ele e sim uma fraude. E, se for um falso positivo, como acontece com nós, humanos, a máquina aprende e se adapta automaticamente. É desta maneira que ela se torna cada dia mais eficiente.

Outras vantagens de utilizar a Inteligência Artificial além da prevenção às fraudes, são: o ganho de tempo e redução de custos de análise, aprimoramento do processo de decisão de crédito e melhoria na cobrança, entre outros benefícios.

Aproveite e leia:

O aumento pela procura de crédito cresce em todas as classes de renda. Essa é a hora de ajudar o cliente a solucionar seus problemas, estreitando assim o relacionamento. E uma política de crédito eficiente faz toda a diferença, ao agilizar o processo de concessão e assegurar que as informações relevantes sobre o tomador de empréstimo foram consultadas e as condições corretas foram determinadas.

Política de crédito é um conjunto de normas e critérios que cada empresa utiliza para financiar ou emprestar recursos a seus clientes. São fatores que cada companhia deve estabelecer. Sua criação, contudo, deve considerar a realidade e o momento do negócio e o perfil do solicitante. Isso quer dizer que as regras não precisam ser fixas ou imutáveis. Alterações pertinentes e relevantes para a avaliação de crédito podem ser feitas sempre que forem necessárias.

O desafio é reduzir o ciclo de concessão sem perder a qualidade na análise. O que quer dizer que cada situação exige um tipo de ação e uma política de crédito específica. Cabe ao gestor desenvolvê-la de acordo com as necessidades e possibilidades de seu público-alvo, os produtos de crédito ofertados e as características do seu negócio. Esse entendimento é fundamental tanto para a saúde financeira da carteira de clientes como para próprio benefício dos clientes.

Além disso, é importante destacar que a empresa pode ter mais de uma política de crédito. Isso vai depender do seu modelo de negócio, tamanho e até histórico de concessões de crédito. Pode parecer complicado, mas as tecnologias tornaram tudo mais simples, independentemente do tipo de política usada.

Em uma análise de crédito tradicional, não automatizada e feita a partir de uma quantidade limitada de informações, potenciais clientes podem ser rejeitados mesmo tendo capacidade de honrar seus compromissos. Desta forma, negócios são perdidos.

Entretanto, é possível combinar Big Data com Inteligência Artificial e Machine Learning para avaliar milhões de informações públicas e abertas disponibilizadas em fontes de dados e na Internet, descobrir perfis de consumidores com alto potencial de honrar seus compromissos e ampliar a concessão de crédito. A eficiência deste tipo de solução pode aumentar em até 20% a rentabilidade e ser utilizada por redes varejistas, instituições financeiras e muitos outros setores.

Toda a operação se dá a partir do desenvolvimento de um processo que realiza análises automaticamente e aprende com elas, tendo como base algoritmos que identificam padrões capazes de prever o comportamento dos consumidores. Com esses padrões gerais, é possível olhar para o cliente de maneira personalizada nas políticas de crédito.

Hoje, é impossível ser eficiente na concessão de crédito sem ferramentas de Business Analytics e Big Data. São tecnologias essenciais no processo que permitem analisar cada cliente com segurança, de acordo com a política de crédito estabelecida por cada empresa, além de identificar o produto mais adequado para cada necessidade. Tudo de maneira rápida e precisa, as ferramentas possibilitam coletar e cruzar um grande volume de informações que auxiliam na tomada de decisão em segundos, incluindo na base muitos potenciais clientes que ficariam de fora das concessões em sistemas tradicionais.

Assim, as tecnologias dão suporte para desburocratizar e democratizar o acesso ao crédito e prometem com isso criar novos modelos de negócios. Em 2020, mais do que nunca, a tecnologia estará a serviço da eficiência, garantindo cada vez mais tratamento personalizado para o consumidor e segurança para clientes e empresas.