A demanda por crédito em janeiro na comparação com dezembro caiu 8%, provocado pelos fatores sazonais, conforme Índice Neurotech de Demanda por Crédito (INDC). O indicador mede mensalmente o número de solicitações de financiamentos nos segmentos de varejo, bancos e serviços. No acumulado de 12 meses até janeiro, porém, a tendência de alta foi mantida e houve crescimento de 22%.

Nesta base de comparação, o destaque ficou com o setor de serviços que liderou a demanda de crédito com um desempenho de 62%, seguido por bancos e financeiras (+19%). Embora com alta bem menor, varejo também registrou desempenho positivo, de 17% nos últimos 12 meses.

Na comparação mensal (janeiro-dezembro), a maior queda ficou com o segmento de varejo (-30%), seguido de serviços (-27%). Já bancos e financeiras registraram alta de 3%. Este movimento negativo é considerado normal devido à sazonalidade. “Historicamente, janeiro e fevereiro são meses de baixa para o comércio. Não deve ser diferente esse ano, que tem o agravante de menos pessoas consumindo, com maior desemprego e maior endividamento”, observa o diretor de Produtos e Sucesso do Cliente da Neurotech, Breno Costa.

Índice Neurotech de Demanda Por Crédito aponta consistência na recuperação

Apesar da conjuntura menos favorável, Costa destaca que a demanda por crédito tem demonstrado consistência na recuperação pós-pandemia. Desde os meses de março e abril de 2020, ápice do isolamento social, a busca por financiamento tem apresentado alta em quase todos os meses, com exceção de outubro (estabilidade), novembro (-4%) e agora janeiro (-8%).

“Há um apetite do brasileiro por crédito. O consumo foi impossibilitado no início da pandemia, o que gerou a forte alta da demanda por recursos a partir de maio. Depois deste movimento, o comportamento está mais tímido, até por conta de toda a incerteza que ainda paira na economia. Mesmo assim, a tendência de crescimento continua”, analisa.

Acompanhe o INDC.

Leia também: INDC de novembro registra expansão de 13%

Para aumentar as vendas e os lucros do negócio, muitos empreendedores do varejo recorrem à oferta de diversas opções de pagamento. O famoso carnê e o cartão de loja são exemplos claros.

Mas esse tipo de operação envolve riscos, como a inadimplência, que traz prejuízo e impacta de forma negativa o crescimento e a saúde financeira do estabelecimento. Imagina precisar recorrer a empréstimos para cobrir um eventual rombo no capital de giro após uma estratégia mal planejada?

Para evitar que situações como essa aconteçam, é fundamental que o seu negócio faça uma gestão de risco de crédito eficaz. E isso é possível a partir de dados concretos, reais, que indiquem qual caminho seguir e que auxiliem na tomada de decisão.

Um dos caminhos é apostar na análise de dados por meio da eficiência da Inteligência Artificial.

Separamos quatro dicas de boas práticas para a gestão de risco no seu negócio com a ajuda da tecnologia:

Verifique o perfil do cliente: com o Big Data, é possível identificar rapidamente e de forma eficiente qual é o histórico de pagamento e inadimplência de cada cliente. Desta forma, o risco de conceder crédito para um cliente com score baixo no mercado é menor, ocasionando na elevação de negócios da empresa.

Tenha segurança nas transações: a internet é um espaço bastante amplo para aplicação de fraudes e ataques. Com a ajuda dos algoritmos inteligentes e de ambientes estáveis e confiáveis, as transações tornam-se mais seguras tanto para os clientes (que fornecem dados pessoais às empresas) quanto para as organizações, que podem diminuir o risco de fraude;

Defina limites de créditos: para evitar que a empresa sofra no futuro e tenha grandes prejuízos com a inadimplência, o ideal é definir um limite seguro de crédito. A Inteligência Artificial pode analisar o seu momento, cenário econômico, perfis de compras em outras lojas, entre outras variáveis, podendo conceder o crédito, mas limitando o valor do consumo.

Automatize as análises: essa experiência é importante para afastar os processos lentos e burocráticos que existiam anteriormente na concessão de crédito no varejo. Isso porque essas análises geravam informações rasas sobre o cliente, além da demora que provocava a desistência e vendas perdidas. Ou seja, a eficiência do Big Data no processo de concessão de crédito torna a experiência melhor, fidelizando e aumentando o volume de transações. Também é possível automatizar as políticas definidas pela empresa, filtrando o perfil do cliente desejado logo no início do processo.

São muitas possibilidades para livrar a sua empresa dos riscos, que trazem prejuízo e instabilidade.

E a Neurotech é parceira quando o assunto é tornar dados dispersos em informações confiáveis que gerem novas oportunidades de negócios para que você obtenha resultados expressivos com o seu público.

Vamos conversar? Faça um diagnóstico gratuito com a gente!

É comum ouvirmos por aí que os dados são o novo petróleo. E nós sabemos que essa frase faz muito sentido e ajuda a discutir a relevância das informações digitais neste momento como uma ferramenta que permite sucesso nos negócios, mais vendas e clientes satisfeitos.

Por isso, a gestão desses dados é fundamental para direcionar o sucesso na tomada de decisão, seja em qual for o setor em que sua empresa atua.

E nesse contexto está a governança de dados, uma política que visa a assegurar a transparência e a proteção desses dados, garantindo confiabilidade durante todo o ciclo de tratamento das informações.

É o nome dado para a gestão de dados, no mais alto nível de análise, que busca garantir a integridade e a proteção das informações coletadas.

Dessa forma, exige investimentos em sistemas e na infraestrutura de armazenamento para suportar grandes demandas de dados estruturados e não estruturados. E também exige envolvimento da organização, com a implementação de políticas corporativas, treinamento e afeiçoamento dos profissionais envolvidos nesse processo.

As novas tendências mercadológicas, impulsionadas pela transformação digital, trouxeram para o centro das discussões o tratamento correto para as informações pessoais de cada indivíduo.

E você sabe que essas informações são valiosas e permitem conhecer mais sobre o seu cliente e personalizar as experiências para ele no ambiente virtual.

É um processo que contribui para que as empresas que gerenciam dados tenham respostas para essas perguntas:

Ter uma governança de dados eficiente beneficia setores estratégicos, como vendas e marketing (com melhor visão sobre preferências do cliente), financeiro (relatórios consistentes e precisos), gestão de riscos, recursos humanos, entre outros.

O propósito da governança de dados é atuar como autoridade articuladora, estabelecendo diretrizes, liderando iniciativas de melhoria e comandando a gestão dos dados dentro de uma organização. E isso é feito alinhando a tecnologia, os processos e as pessoas envolvidas para definir papéis, responsabilidades e procedimentos assertivos.

Dados ruins, confusos, inconsistentes e vulneráveis resultam em problemas frequentes para os gerentes das organizações. Essas deficiências contribuem para perda de tempo, aumentam os custos, enfraquecem a tomada de decisões e irritam os clientes. Dessa forma, tudo fica mais difícil para implementar qualquer tipo de estratégia com a utilização de dados.

Segundo análises do Harvard Business Review, em média, 47% dos registros de dados recentes têm ao menos um erro crítico, impactando negativamente no resultado das atividades.

Nesse sentido, uma governança de dados eficiente resulta em melhores dados, informações mais enxutas e limpas, permitindo análises assertivas, tomada de decisão mais ágil e correta e, por fim, beneficiando os resultados da sua empresa.

Com foco no uso de Inteligência Artificial, Big Data e Machine Learning, a Neurotech transforma um mundo de dados em informações confiáveis e relevantes para que nossos clientes conquistem resultados expressivos, prevendo novas oportunidades de negócios.

A demanda por crédito nos segmentos de varejo, bancos e serviços fechou dezembro com um volume 29% superior ao que havia registrado em janeiro de 2020. O resultado consolida a recuperação observada a partir do segundo semestre pelo Índice Neurotech de Demanda por Crédito (INDC), que mede o número de solicitações de financiamentos mensais nestes setores.

O principal responsável por esta inversão de tendência foi o setor de serviços que registrou índices sempre superiores a 34% de aumento a partir de agosto e encerrou o último mês do ano com um crescimento de 122% em relação a janeiro.

“Aproveitando o estímulo do auxílio emergencial, muitos consumidores decidiram solicitar financiamento para completar o valor necessário com o objetivo de reformar a casa, por exemplo, ou renegociar dívidas”, afirma o diretor de Produtos e Sucesso do Cliente da Neurotech, Breno Costa.

Bancos e financeiras registraram um acréscimo de 16% em relação a janeiro, enquanto o varejo teve um crescimento de 44% na mesma base de comparação.

Na medição direta entre o volume de dezembro em relação a novembro a variação positiva foi de 4%. Já na observação sobre o número de pedidos feitos nas duas semanas anteriores ao Natal de 2020 em relação ao mesmo período do ano passado, houve uma retração de -4%.

No que se refere aos pedidos de empréstimos feitos no varejo, os destaques ficaram com as lojas de departamento e o setor de vestuário. As lojas tiveram o maior crescimento na observação de curto prazo, com uma alta de 71% entre dezembro e novembro. Já os estabelecimentos especializados em roupas e acessórios cravaram um aumento de 170% entre as propostas feitas no intervalo de janeiro a dezembro.

Acompanhe o INDC.

Por: Marcio de Lucas

Por: Marcio de Lucas

Se a gente voltasse no tempo e perguntasse a Aristóteles se ele é de Humanas ou de Exatas, observaríamos uma autêntica expressão de dúvida. Por que um filósofo, que, por definição, é um amigo do conhecimento, dividiria os acontecimentos do mundo em caixinhas se eles acontecem todos ao mesmo tempo? Talvez devêssemos recuperar algumas ideias do passado.

A gente se acostuma a definir Humanas e Exatas como áreas opostas do conhecimento — e até usa esses termos para identificar tribos universitárias. Nesse jogo de esteriótipos, pessoas de Humanas são aquela galera que passa os dias com a cabeça na lua, pensando sobre os rumos da sociedade ou recitando palavras complicadas. Enquanto isso, as pessoas de Exatas estão mergulhadas num caderno cheio de fórmulas matemáticas, tentando sobreviver até a próxima prova de cálculo.

Apesar dessa ideia fazer sentido nos dias de hoje, no passado as coisas eram muito diferentes — e não me refiro apenas à época de Aristóteles. A estatística, por exemplo, surgiu como uma “Ciência do Estado”, destinada a compreender e analisar dados populacionais e oferecer informações para a administração pública. Sociólogos como Émile Durkheim utilizaram pesquisas e relatórios publicados por demógrafos como base para construção de teorias sobre como a sociedade funciona e se transforma. Entre os grandes pensadores da filosofia e grandes matemáticos da história, há muitas interseções. Blaise Pascal e René Descartes, por exemplo, são conhecidos tanto por terem realizado grandes contribuições para a lógica e para matemática como por terem escrito alguns dos maiores tratados filosóficos da humanidade.

Mas o que explica essa aproximação do passado? Pois bem, como fundamento dessa união está o fato de que matemática e estatística oferecerem superpoderes para produção de conhecimento.

Num universo cheio de mistérios e fenômenos, testes de hipóteses, modelagem estatística e simulações computacionais são exemplos de instrumentos capazes de produzir ou sumarizar evidências para validar ou desacreditar teorias, sejam elas sobre eletromagnetismo, evolução ou sobre as causas e consequências da violência.

Então o que aconteceu para chegar no ponto em que estamos hoje? As Ciências Humanas deixaram de fazer ciência? Te adianto que a resposta é não, mas, para explicar melhor o que aconteceu, preciso te contar da minha jornada das Ciências Sociais até o meu trabalho como Analista de Dados na Plataforma Neurolake, da Neurotech.

Pois bem, no final do ensino médio, cheguei à conclusão de que eu me parecia mais com alguém de Humanas e, por isso, optei por cursar Ciências Sociais na Universidade Federal do Ceará. Durante a graduação, me deparei com uma avalanche de autores e ideias que disputavam o lugar de melhor interpretação sobre comportamento, cultura e política. Porém, aos poucos — fortemente motivado pela leitura do livro Designing Social Inquiry, de Robert Keohane e Sidney Verba — percebi que, em meio à pluralidade, os autores aglutinam-se em dois grandes grupos: aqueles que aderem ao método científico, os cientificistas; e aqueles que o rejeitam, os interpretativistas.

Foi quando ficou mais claro para mim que, de longe, Ciências Humanas podem parecer uma coisa só, mas, na prática, há pessoas se dedicando a atividades muito diferentes. De um lado, há, desde a década de 1960, a popularização dos campos de Estudos Culturais, que se dedicam a construir narrativas sobre a sociedade, contestando as regras e os procedimentos científicos. De outro, periódicos acadêmicos como American Sociological Review e Political Analysis demonstram como a tradição de unir métodos matemáticos e estatísticos a investigações sobre fenômenos sociais manteve-se viva e evoluiu para formas bastante sofisticadas.

Quanto mais eu ouvia falar sobre dados e estatísticas, mais eu enxergava nelas um caminho para oferecer respostas sólidas e embasadas em evidências para questões importantes da sociedade. A partir daí, dediquei-me a aprender mais sobre metodologia, com o objetivo de entender como autores obtêm os resultados que reforçam ou contestam suas hipóteses.

O primeiro passo foi ler mais artigos que tratavam do tema. Depois passei a cursar disciplinas nas áreas de econometria, estatística e computação e, por fim, me mudei de Fortaleza para Recife com o objetivo de cursar o mestrado em Ciência Política na Universidade Federal de Pernambuco. Durante o mestrado, continuei com a estratégia de cursar disciplinas em outros departamentos, mas comecei a investir bastante energia na construção de miniprojetos para experimentar novas técnicas e tecnologias.

Sem que eu percebesse, estava, aos poucos, escolhendo uma carreira. Quanto mais contas eu fazia e mais linhas de código escrevia, mais potencial eu enxergava no uso dessas ferramentas para solução de problemas práticos do mundo real.

Foi então que eu resolvi buscar um espaço no mercado onde eu pudesse aprender e contribuir para construção de produtos baseados em dados, que unissem Humanas e Exatas para gerar impacto econômico. E foi na Plataforma Neurolake que eu mergulhei fundo nessa ideia. Hoje integro a equipe de Inteligência de Dados, dedicada a construir variáveis e indicadores que permitam segmentar o público de nossos clientes sob perspectivas de negócio, oferecendo mais informação para auxiliar na tomada de decisão.

“Apesar de se tratar de uma trajetória pessoal, interpreto os passos que segui como indicativos de uma nova tendência: cada vez mais estudantes trilham o caminho para uma nova união entre Humanas e Exatas.”

Percebo que mais sociólogos, cientistas políticos e historiadores têm aderido a métodos quantitativos; e, ao mesmo tempo, mais cientistas da computação, estatísticos e engenheiros têm se dedicado a compreender dinâmicas que envolvem comportamento e atitudes de indivíduos. Como indicativo disso, basta olhar a coautoria e as referências bibliográficas de artigos que tratam de Análise de Sentimentos e Processamento de Linguagem Natural.

Por trás dessa dinâmica, está um novo mundo que tem se erguido em torno dos dados. Passamos a produzir e coletar muito mais informação. Cada perfil em uma rede social, cada histórico de compras e cada nova pesquisa de opinião pública representa uma possibilidade de entender melhor os fatores que afetam o sucesso ou fracasso de um negócio. Nesse novo horizonte, é a oferta que cria a demanda e, quanto mais dados, mais procura por profissionais que saibam transformá-los em conhecimento. Para o futuro, espero ver muito mais pessoas de Humanas e de Exatas andando juntas no recreio.

Esse texto é fruto das provocações geradas a partir da minha participação na live “Sou de outra área e me apaixonei por Data Science, e agora?”. Se você gosta do tema, vale muito a pena vê-la. Muito gente massa participou e respondemos várias perguntas sobre o processo de migrar de para Data Science a partir de diversos pontos de partida:

Marcio de Lucas - Analista de Dados na equipe de Inteligência de Dados na Plataforma Neurolake

Mestre em Ciência Política pela UFPE

A demanda por crédito no varejo voltou a subir em novembro, após duas quedas mensais consecutivas. É o que mostra o Índice Neurotech de Demanda por Crédito (INDC), que mede o número de solicitações de financiamentos nos segmentos de varejo, bancos e serviços. O crescimento foi de 13% no mês passado em relação a outubro, que havia apresentado queda de 10%. Em setembro, a retração havia sido de 5%, sempre na comparação com o mês anterior.

“Esse incremento da busca por crédito é bem comum no mês de novembro, com os consumidores aproveitando as promoções da Black Friday, que este ano obteve um desempenho um pouco mais tímido que em 2019”, diz o diretor de Produtos e Sucesso do Cliente da Neurotech, Breno Costa.

A demanda por crédito no segmento de móveis foi a que apresentou maior incremento, com alta de 47% no mês. Em segundo lugar vem vestuário (+17%), seguido por os eletroeletrônicos (+11%) e lojas de departamentos (9%).

No acumulado, porém, a demanda total de crédito recuou 4% em novembro em relação a outubro, puxada pelos segmentos de bancos e financeiras (-6%) e de serviços (-11%). O movimento está relacionado ao comprometimento da renda do brasileiro, perspectiva de fim do auxílio-emergencial, além do crescimento do consumo de fim de ano, que leva à preferência da busca por crédito em lojas.

Ao mesmo tempo, o adiantamento do 13º salário também leva à redução da necessidade de crédito. “É um movimento sazonal esperado por bancos e financeiras. Estamos vendo a realidade bater à porta e a demanda se arrefecer, mas é esperada uma retomada a partir de janeiro, o que também é um movimento sazonal”, explica Costa.

No ano, o INDC ainda apresenta alta acumulada de 24%. Até outubro era de 30% na comparação com janeiro. “A princípio era esperada uma reversão da queda total, mas percebe-se que o brasileiro se manteve mais reticente por conta do aumento do endividamento e incerteza. Além disso, houve um forte aumento dos preços dos produtos essenciais, o que reduz o consumo de outros bens”, diz.

Confira o INDC do mês passado.

A demanda por crédito se manteve estável em outubro em relação a setembro, indicando que a recuperação do consumo pós-pandemia pode ter atingido o limite. Desde maio, o Índice Neurotech de Demanda por Crédito (INDC), que mede o número de solicitações de financiamentos mensais nos segmentos de varejo, bancos e serviços, vinha registrando alta na casa de dois dígitos, porém em setembro o crescimento ficou em somente 3% e em outubro houve uma leve retração de - 0,1%. No acumulado do ano, a demanda por crédito encontra-se 30% maior que em janeiro.

“A vontade de comprar existia, mas o consumo foi impossibilitado por conta do isolamento social. Além disso, as incertezas fizeram os brasileiros ficarem mais reticentes em gastar. Com a abertura da economia e a visão de que o pior da crise já passou, as pessoas ampliaram seu crediário para irem às compras. Agora estamos vendo a realidade bater à porta e a demanda se arrefecer”, explica o diretor de Produtos e Sucesso do Cliente da Neurotech, Breno Costa.

A acomodação do INDC no mesmo patamar não é vista como sinal de crise. Ao contrário, pode até significar uma pausa para obter fôlego e ampliar o consumo de fim de ano, com a Black Friday e o Natal. De qualquer forma, é preciso observar que o brasileiro já está endividado, houve uma queda considerável da renda e o auxílio-emergencial aparentemente está com os dias contados.

Ao analisar o INDC de forma segmentada, é possível perceber que houve aumento na demanda por crédito nos bancos e financeiras e no setor de serviços, de 1% e 3%, respectivamente. Entretanto, este movimento foi compensado do lado negativo pela queda de 10% do varejo.

“A princípio era esperada uma reversão deste movimento, mas percebe-se que o brasileiro se manteve mais reticente por conta do aumento do endividamento, incerteza e perspectiva do fim do auxílio emergencial. Além disso, houve um forte aumento dos preços dos produtos essenciais, o que reduz o consumo de outros bens”, diz Costa.

Dos setores analisados que compõem o varejo dois chamam atenção negativamente: moveleiro e eletro. O primeiro demonstrou uma forte queda de 72%. Já o eletro recuou 3%. Por outro lado, supermercados, lojas de departamento e vestuário apresentam alta de 14%, 11% e 10%, respectivamente quando comparados os meses de outubro e setembro.

No acumulado do ano, todos os segmentos estão em terreno negativo, com exceção de vestuário e lojas de departamento, além dos classificados como outros.

Confira todos os artigos sobre o INDC.

Para deixar um código legível, é preciso saber como estruturar um código e mantê-lo legível. Existem diferentes formas de fazer isso e, aqui, você receberá 6 dicas incríveis para alcançar excelentes resultados.

Muitas vezes, quando você está desenvolvendo um projeto na empresa em que você trabalha, um projeto pessoal ou aquele trabalho em grupo da faculdade, eventualmente outras pessoas vão acabar mexendo no seu código.

Muito provavelmente até mesmo o seu “eu” do futuro vai fazer isso, seja para solucionar algum bug ou usar como referência e descobrir como foi implementada aquela funcionalidade.

Por isso, o melhor a se fazer é deixar o código bem legível, procurando evitar aqueles erros bobos ou escrever coisas que só você vai entender e que provavelmente nem o seu “eu” do futuro vai se lembrar o que é.

Se você está na faculdade, mas ainda não tem o costume de adotar boas práticas de código, tudo bem! Essa é a melhor hora pra começar a aprender, é aí que se inicia a sua jornada com a “Força”!

Para começo de conversa, projetos pequenos são perfeitos para adquirir boas práticas de código. Mesmo se o projeto não for pequeno, mas você tiver a oportunidade de começar do zero, não deixe essa chance escapar — porque nós sabemos como essa história termina: vira uma verdadeira bola de neve!

E ninguém gosta de ter débito técnico e ter que refatorar código, não é verdade?

No caso de você estar iniciando na vida de programação, não se preocupe se você já fez aqueles códigos “gambiarrosos”, cheios de prints e que não são muito bonitos. É normal não se ter essa skill logo de cara, mas é importante você ter em mente que treinar boas práticas será muito importante para os seus códigos futuros.

E claro toda hora é hora para se trocar ideias sobre práticas de código, aprender aqueles macetes, algum atalho novo, pedir uma dica de plugin, experimentar novas ferramentas como aquela IDE que você viu seu amigo usar, tentar usar aquela função que você viu no Stack Overflow que resume o seu código de 10 linhas em apenas 3.

O importante é descobrir o que mais te agrada e que te deixa satisfeito para escrever uma boa linha de código.

Assim como existem várias linguagens, também existem diversas formas para se escrever e se estruturar um bom código. Você não precisa dominar todas as técnicas, mas precisa aprender o básico, jovem padawan.

Algumas dessas técnicas são básicas como um “ABC” e não são relacionadas à linguagem que você estiver usando, então pode aplicá-las em qualquer caso.

Escolha um padrão para declarar as variáveis do seu projeto e o siga fielmente, se não seu projeto irá se tornar um carnaval de variáveis com formatos diferentes. Existem vários padrões que você pode adotar, algumas comunidades de certas linguagens já utilizam um padrão por ser mais aceito.

Você pode adotá-lo ou escolher um que seja mais agradável pra você, contanto que o mantenha como padrão em todo o seu projeto. O recomendável, claro, é seguir com o que já é aceito pela comunidade da linguagem que você escolheu.

Uma dica que eu dou para quem programa em Java, quando for criar uma variável que faça sentido ser formada por duas palavras ou mais, evite utilizar o caractere underline para unir as duas palavras. Uma forma melhor é escrever tudo junto, no formato Lower Camel Case. Por exemplo: scoreRange, performanceValue.

Esse caractere acabou me dando um pouco de dor de cabeça com o Spring Data, ao tentar criar queries automáticas utilizando as variáveis que foram declaradas com underline.

Nem você nem a pessoa que vai ler seu código são mágicos (eu acredito).

Então tente não tirar números da cartola e jogá-los no meio do código! Se aquele número está ali, ele tem uma explicação. Crie uma constante e nomeie ela de forma que a pessoa que irá ler o seu código (ou até mesmo você no outro dia) vai entender o porquê de existir aquele valor ali.

Não crie aquelas variáveis misteriosas, como a famosa “aux”, ou easter eggs e ou outros nomes que você esteja acostumado a utilizar (já me deparei até com alguns engraçados como “tapi” e “oca” ou “tika”). Os nomes das variáveis têm que estar alinhados com o papel que elas terão no código. Se você realmente está querendo criar uma variável auxiliar, crie com um nome que indique que ela é uma variável auxiliar mas para aquela determinada ação.

Aprender a usar corretamente o Git é muito importante. Além de ser uma ferramenta de versionamento, ele pode te ajudar na organização do seu código.

Uma funcionalidade que eu acho muito interessante é o Git Hooks: com ele você pode definir um padrão de mensagem para os seus commits, ou seja, só serão aceitos commits que estiverem dentro do regex estabelecido (isso é muito interessante de se utilizar com outras ferramentas como Trello e Jira, para organizar cada issue).

Com o Git Hooks também é possível configurar a execução de testes unitários e o commit só será aceito caso todos os testes tenham sucesso. Isso evita bastante que aquele erro que passou despercebido suba para o repositório.

Na minha opinião, o Git é uma ferramenta rica que te permite fazer diversas coisas, muitas dessas você só aprende integrando ele de verdade com o seu projeto e colocando a mão na massa, então tem que codar.

Existem diversas padrões de organização de projeto, normalmente são estruturados em camadas de serviços, em que cada camada fica em uma pasta do projeto e lá ficarão os códigos das features específicas que realizam funções semelhantes.

Por exemplo: uma camada que realiza apenas acessos ao banco, o Service. Como trabalho com um projeto web com Spring Boot, uma forma que aprendi a dividir as camadas foi em Controller, onde ficará o controle das rotas da API; Service, onde posso realizar operações com o banco, busca, atualização, inserção; Adapter, onde irei realizar alguma regra de negócio, acessar as propriedades do código ou chamar algum micro-serviço.

Outro padrão de estruturação já famoso é o MVC (Model-View-Controller), bastante adotado em projetos web com javascript.

Todos os modelos de arquitetura se baseiam em agrupamento de código por conceito, para otimizar ainda mais a sua vida de programação. Não estou falando que esses padrões que citei logo acima são unanimidade, o ideal é você procurar uma arquitetura que melhor se encaixa ao seu projeto e que vai te ajudar a organizá-lo. Além disso, um projeto organizado é outro nível, então vale muito a pena pesquisar pelo melhor modelo.

Um ponto fraco da maioria dos programadores é a documentação, sendo que a documentação só está ali para ajudar. Já ouvi muitas vezes que um código bem escrito não precisa de documentação.

OK, isso pode até ser verdade em alguns casos, mas, em um projeto grande, nada tira o fato de que muitas vezes é importante aquele comentário para entender aquela função, saber especificamente o que ela recebe e o que vai retornar.

Falando sério, documentar não faz mal nenhum — muito pelo contrário, só vai te ajudar! Também, é claro, ajuda o próximo desenvolvedor que for mexer no código, já que ele vai conseguir entender mais rápido o contexto, além de que não vai ficar te perguntando de instante em instante.

A documentação pode ser no próprio README (sério, se esse arquivo está com esse nome, ainda mais em Caps Lock, é porque você TEM QUE LER antes de começar o projeto!). Isso já é bem interessante, mas se tem algum outro arquivo de texto que você queira criar por fora, se lembra de deixar organizado para acabar não confundindo ainda mais a pessoa que vai ler.

Existem inclusive algumas ferramentas de documentação automática que são bem interessantes, como o Swagger UI para APIs ou o Asciidoctor.

Existem várias ferramentas que podem te ajudar nessa missão. Escolha a arma que melhor se ajusta à sua necessidade e que a força esteja com você.

O primeiro passo dessa etapa é escolher a sua IDE ideal. Pode ser aquela que tem um tema mais agradável ou a que tem mais funcionalidades interessantes para o seu projeto e, se você for mais simples, pode até ser um editor de texto normal mesmo, contanto que isso te ajude a programar. Mas entenda que uma boa IDE pode impulsionar bastante a sua produtividade.

Como eu estou programando em Java já a algum tempo, comecei pelo Eclipse e confesso que não era muito satisfeito até migrar para o IntelliJ.

Foi rápido para me acostumar, até mesmo porque as duas interfaces são bem parecidas, mas me senti mais confortável com o IntelliJ e com os plugins que ele me permite utilizar. Se no futuro aparecer alguma outra IDE mais atraente, vou testar com toda certeza.

Plugins para padronização e correção de código também são ferramentas muito interessantes que facilitam a vida de qualquer um.

Então vale a pena perder um pouco de tempo dando uma pesquisada e configurando, porque, depois disso, vão estar à distância de apenas um atalho do seu teclado e seu código vai estar lá todo lindo, formatado com a identação padrão que você programou!!

Uma dica que eu dou é você utilizar duas ferramentas: Lint e o plugin de formatação do Google. Lint é uma ferramenta de verificação automática, que identifica padrões problemáticos no seu código, warnings e erros que podem gerar algum bug.

A outra ferramenta é o plugin de formatação do Google, que varia para cada linguagem que você for utilizar, mas que já deixa tudo em um padrão muito legal.

Boas práticas não são adquiridas do dia para a noite, somente com o tempo você pode se tornar um jedi, mestre em clean code e, claro, a prática é amiga da perfeição.

Com o tempo, as boas práticas vão se tornando mais naturais, mas alguns detalhes sempre podem acabar passando despercebidos.

Por isso, as técnicas e ferramentas sempre irão ajudar desde o iniciante até o mais experiente. Nós sabemos como um código legado malfeito pode ser um terror (ou não… existem, sim, esses casos raros).

Então seja o cara legal da vez, faça um código limpo e não crie um monstro para que o próximo desenvolvedor cuide. Não vá para o lado negro da Força.

Bom isso é tudo pessoal, obrigado! Até uma próxima e que a Força esteja com vocês!

Esse conteúdo foi escrito pelo Douglas Vasconcelos, Software Engineer na Neurotech, e originalmente postado no blog da Neurolake.

As aplicações de Inteligência Artificial que se adequam ao seu negócio são inúmeras. Ao unir essa tecnologia aos seus processos de decisão você pode usá-la de diversas formas, melhorando a sua gestão e tomando decisões baseadas em fatos, e não apenas em intuição ou informações incompletas.

Como resultado, você tem a chance de oferecer uma melhor experiência para os seus consumidores.

Se você deseja saber qual solução é a ideal para os desafios que a sua empresa enfrenta, conte com a Neurotech! Somos especialistas em Big Data e Inteligência Artificial e podemos ajudar você a se destacar no mercado.

Seria tão mais fácil se pudéssemos prever o futuro em diversas ocasiões, não é mesmo? Mas saiba que é possível ter uma certa previsibilidade no mundo dos negócios graças aos avanços da tecnologia. Por meio de ferramentas de Analytics e Big Data, é possível analisar o mercado e tomar decisões mais assertivas para solucionar e prevenir problemas, ajudando no crescimento do seu negócio.

A busca da resposta para o que provavelmente vai ocorrer em cada caso, ou seja, antecipar acontecimentos, é chamada de Análise Preditiva. Quando bem utilizada, ela pode gerar ótimos resultados e valor para o seu negócio. Sabe por quê? Porque ela é capaz de identificar padrões nos dados em casos passados e construir soluções capazes de prever o que pode ou não acontecer em situações futuras.

Estamos falando de uma das análises mais conhecidas e utilizadas no mercado porque permite que os gestores tomem decisões melhores e mais rápidas com base no provável resultado da decisão a partir das informações disponíveis.

Vamos exemplificar. Imagine uma grande rede varejista que planejava melhorar e crescer na sua performance no e-commerce. Porém, um dos seus entraves era de que muitos dos seus consumidores tinham um limite de crédito baixo, que não permitia compras com ticket médio maiores e que fizessem a diferença para a rede. Foi aí que eles apostaram na tecnologia para aumentar a capacidade de compra dos seus potenciais consumidores, sem representar mais exposição de risco à inadimplência.

Isso foi possível porque a análise preditiva checou o risco, estimou adequadamente os limites de cada cliente de forma personalizada e passou a aprovar o crédito para compras online em tempo real. Menos perda de tempo e mais assertividade no resultado. Nesse case que usamos para exemplificar, o cartão passou a ser emitido em, no máximo, sete minutos, aumentando o poder de compra e a satisfação do cliente.

Vamos usar mais um exemplo. A análise preditiva foi fundamental para que uma das maiores seguradoras do Brasil reduzisse os índices de sinistralidade dos automóveis. Isso foi possível com o desenvolvimento de uma base de dados com informações seguras para melhorar a tomada de decisão – tudo baseado em Inteligência Artificial.

Essa plataforma integrava a aferição de risco e passou a identificar 17% de potenciais sinistros em apenas 5% das propostas. Ou seja, mostrando como a análise preditiva identifica padrões de comportamento e auxilia na prevenção de riscos, potencializando decisões que vão levar a melhores resultados.

Além disso, empresas de todo o planeta estão usando a análise preditiva para tomar decisões, prever possíveis resultados ou identificar tendências.

Um dos benefícios é o combate a fraudes. Isso porque ela atua na detecção de padrões nos dados que podem estar relacionados a esse tipo de ação, emitindo alertas e ativando mecanismos de proteção. Tentativas de fraudar são frequentes em sistemas bancários ou meios de pagamentos, principalmente, nas operações com cartões de crédito.

Outra vantagem é avaliar as condições de financiamento ou crédito, como o risco de aprovar ou não uma transação ou o tipo mais indicado de financiamento para o perfil do cliente. Trata-se de um processo que pode envolver muitas informações, mas se tratado da forma adequada e com segurança pela análise preditiva leva a ótimos resultados.

Percebeu como a tecnologia pode ajudar a tornar o futuro menos incerto ou, em outras palavras, mais previsível? A grande jogada está no levantamento e aproveitamento dos dados e no uso de tecnologias que possam extrair conhecimento deles. Quando isso é feito de forma satisfatória, negócios conseguem crescer, minimizando riscos e tendo mais assertividade no que realmente faz a diferença.

Para saber mais sobre outros tipos de análise, você pode assistir o vídeo abaixo onde Germano Vasconcelos, PhD em Inteligência Artificial pela University of Kent e Sócio-Fundador da Neurotech, em entrevista com a Jornalista Ana Borges, explica quais são os 4 tipos de análises de dados e suas aplicações nos negócios: análise descritiva, análise diagnóstica, análise preditiva e análise prescritiva.

Você também pode baixar o nosso E-book Transforme dados em Melhores Decisões: Os 4 tipos de análises e suas aplicações

E se você quer saber como e quais tipos de análise se aplicam a sua empresa, faça um diagnóstico com um dos nossos especialistas. A Neurotech é referência em transformar um mundo de dados em informações confiáveis e relevantes para que nossos clientes obtenham resultados incrementais expressivos, prevendo novas oportunidades de negócios.

A demanda por crédito em setembro registrou crescimento de 3% em relação a agosto. Com o resultado, a alta acumulada nos nove primeiros meses do ano chega a 30%, segundo o Índice Neurotech de Demanda por Crédito (INDC), que mede o número de solicitações de financiamentos mensais nos segmentos de varejo, bancos e serviços. O desempenho do mês passado foi puxado pelo setor de serviços, que liderou a procura por crédito, com expansão de 29%.

No mesmo período, o varejo registrou queda de 5%. O que não pode ser visto ainda como desaceleração, na avaliação do diretor de Produtos e Sucesso do Cliente da Neurotech, Breno Costa. Isso porque, inicialmente, setembro tem 30 dias, um a menos que agosto. “E justamente neste ano calhou de ser um sábado (dia de maior venda) a menos”, afirma. Isso por si só representaria uma queda estimada entre 3% e 4%. Outro ponto é que esse comportamento está bem concentrado em lojas de departamentos, algo já histórico para os meses de setembro.

De acordo com o INDC, as lojas de departamento registraram uma queda de 10% nas vendas entre agosto e setembro, o maior tombo entre todos os segmentos de varejo. Dentre os setores, o de supermercados se destacou, atingindo um crescimento de 13%. Vestuário também teve um desempenho positivo ainda que tímido, registrando um avanço de 2% no período.

No ano, o setor de serviços está na dianteira, apresentando crescimento de 73%. Como segundo colocado desponta o bancário que avançou 30% de janeiro a setembro. O varejo, por sua vez, está com um incremento de 12% no mesmo período.

O destaque do setor de serviços pode ser lido como uma busca deste segmento por intensificar linhas de crédito para geração de receita mediante o cenário de crise. Existe uma clara tendência no mercado de verticalização de soluções para as respectivas cadeias produtivas.

Verificando os segmentos que compõem o setor de varejo, o de vestuário consta entre os melhores desempenhos, registrando 34% entre janeiro a setembro. Chama a atenção o pico nas vendas que o vestuário apresentou entre os meses de maio e junho, quando atingiu o patamar de 157%.

Os supermercados, por sua vez, registraram um desempenho de 13% em setembro, mesmo patamar atingido em agosto, mas ainda acumulam um comportamento negativo de 20% no ano. Aqui percebemos um movimento inverso ao do setor de serviços. Este setor foi o menos afetado pela pandemia do ponto de vista de faturamento do varejo. Mas o serviço financeiro carece de investimento em alguns momentos, bem como da presença física dos clientes para tal oferta.

Os eletroeletrônicos, que apresentaram leve retração de 3% em agosto, demonstram estar caminhando para o terreno da estabilidade, com um decréscimo de apenas 1% em setembro.

“Claramente o crédito tem se mostrado uma alavanca para o momento que passamos. Muitos concessores recuperaram a confiança diante das necessidades latentes de consumo, apesar da pandemia. As demandas podem ter mudado de um setor para outro, mas as necessidades estão lá e há crédito para suportá-las”, afirma Costa.

Com a transformação digital cada vez mais presente no dia a dia das empresas, o Big Data é considerado uma excelente ferramenta para garantir a competitividade e permitir mais assertividade na tomada de decisões. Mas, para lidar com um grande volume de informações surge a modelagem de dados, uma técnica para armazenamento dos dados. Descubra mais sobre essa ferramenta neste artigo.

É importante lembrar que não basta apenas coletar os dados e armazená-los de diferentes maneiras - seja em um servidor ou na nuvem. E é nesse momento que entra a modelagem de dados. Essa técnica é usada para a especificação de regras de cada negócio e quais são as estruturas de informações que serão utilizadas no seu banco de dados.

Ela faz parte do ciclo de desenvolvimento de um sistema de informação e é fundamental para o bom resultado do projeto. Modelar dados consiste em desenhar o sistema de informações, concentrando-se nas entidades lógicas e nas dependências entre essas entidades.

Uma modelagem correta permite que diversos sistemas independentes do banco de dados tenham acesso ao armazenamento, para que possam ser trabalhados de forma eficiente.

Essa etapa é uma das mais delicadas e que merece atenção. Um erro durante a modelagem de dados pode inviabilizar a usabilidade do sistema, resultando em retrabalho e reformulação do banco de dados, provocando aumento no custo do projeto de software.

A modelagem de dados não é uma técnica pronta, que possa ser usada em qualquer tipo de negócio. Pelo contrário. É preciso saber muito bem todas as demandas do usuário e conhecer quais tipos de informações serão armazenadas.

O processo de modelagem é organizado em sete fases. Saiba mais sobre elas.

Pré-levantamento: O propósito dessa etapa é coletar, ainda antes de iniciar o projeto, todas as informações relevantes sobre a empresa. Precisa estar claro qual o seu tipo de negócio e o perfil do cliente. É uma fase humanizada, onde se identificam as pessoas envolvidas nas soluções e nos projetos/serviços vendidos. Tudo isso porque é fundamental que produção e comercial tenham um entendimento correto desde o início do projeto.

Levantamento: É o momento de identificar as metas e quais os desejos do cliente com base na sua perspectiva de negócio. Assim, é possível construir um cronograma com todas as atividades a serem realizadas até a implantação da solução. Esta fase é muito importante para o sucesso do projeto, pois um entendimento errôneo dos objetivos do projeto pode gerar respostas corretas para perguntas erradas.

Homologação dos dados: Todos os dados enviados pelo cliente precisam ser homologados.

Preparação dos dados: Nesta etapa, os dados são limpos, selecionados e organizados para aplicação do algoritmo de aprendizagem.

Modelagem: É o momento de selecionar a técnica de modelagem, como Árvore, Regressão ou ML, por exemplo, além de conferir se existem restrições que devem servir de alerta, como mudança de política, troca de score ou adesão de um novo produto. Os parâmetros utilizados na modelagem são documentados e a performance de cada configuração é testada.

Avaliação de desempenho: Tudo precisa ser testado e analisado, sempre com foco no sucesso da solução. Assim, o grau de aprendizagem para novos dados do modelo é construído e avaliado em cada passo.

Implantação: É hora de apresentar os resultados da construção do projeto e instalação do servidor como modelo desenvolvimento. Mas não se trata de fim dos trabalhos. Esta fase homologa a finalização do projeto, marcando o início do acompanhamento da solução. Ou seja, tudo será constantemente analisado e acompanhando, verificando a real eficácia da técnica.

Diferença ente modelagem e mineração

Quando falamos de armazenamento de informações do banco de dados, lembramos também da mineração de dados. Ela se configura como a busca de informações dentro de um sistema que já existe. Ou seja, o analista ainda está conferindo as suas possibilidades e ainda não descobriu o que está buscando.

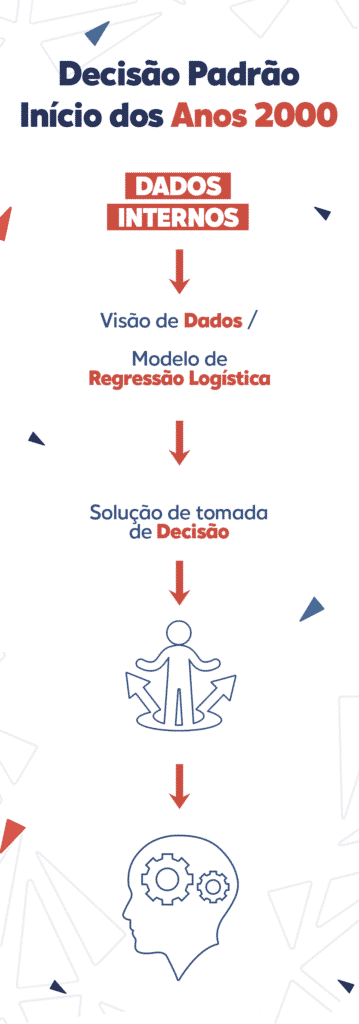

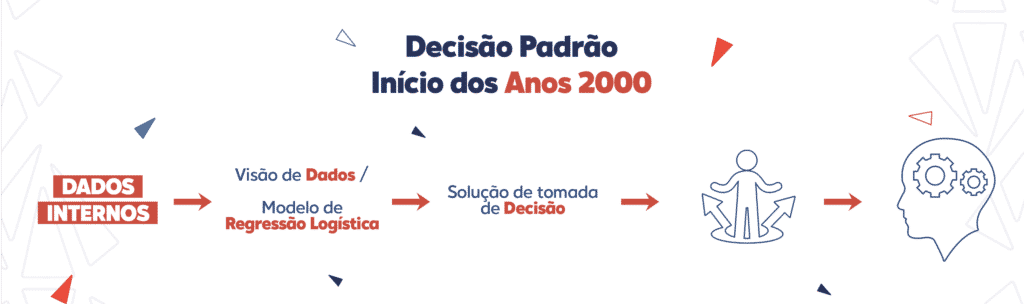

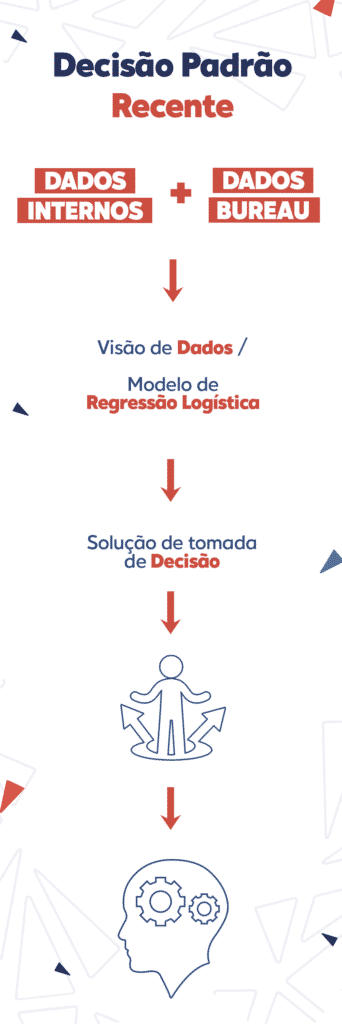

Por: Breno Costa* | 13 de Novembro de 2020

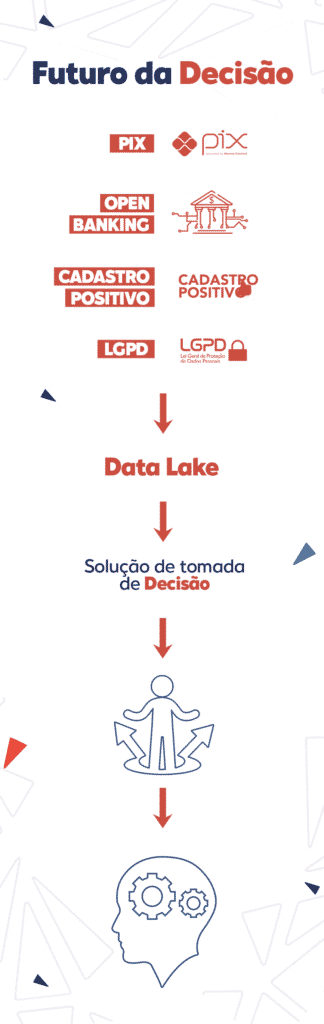

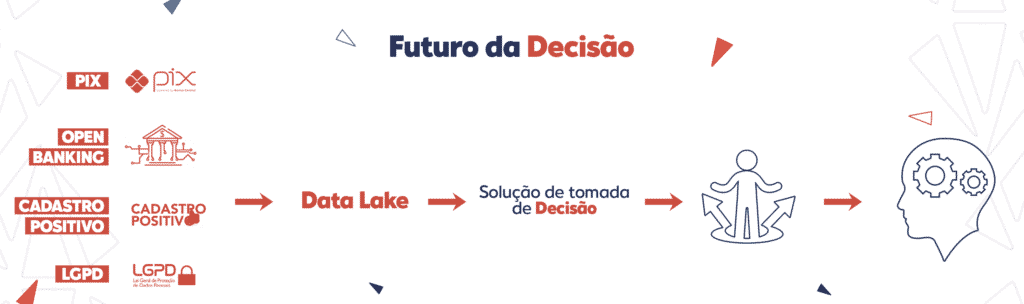

Na hora da concessão do crédito, as possibilidades para interpretação adequada do perfil do consumidor ganharão um patamar bem mais elevado com o advento do cadastro positivo e o open banking, além do PIX, sistema de pagamento instantâneo do Banco Central. O que exigirá dos conectores de dados e fontes organização a agilidade na construção e revisão de modelos, algo que somente uma plataforma integrada conseguirá desenvolver a modelagem adequada.

Os novos desafios impostos pelo acesso a um contingente cada vez maior de dados exigem novas visões de mercado que facilitem o processo de organização para gerir e digerir toda informação disponível.

Esse tripé de iniciativas formará o pilar de sustentação da nova era de dados no processo de tomada de decisão, aliadas à inclusão de milhares de potenciais clientes no sistema financeiro (devido ao PIX). É para acompanhar essa movimentação que a Neurotech investe para otimizar e evoluir soluções como o Fit Analytics, o Riskpack e a Neurolake, que ganhou uma versão mais ampla para escalabilidade dos negócios por meio de mais de 300 aplicações dentro da jornada de relacionamento com o cliente.

Um exemplo do seu potencial é ilustrado por um cliente que necessitava melhorar a concessão do produto, sem impactar na taxa de inadimplência da sua carteira e maximizar sua aprovação. A partir de uma modelagem personalizada realizada, que cruzou dados alternativos, foi possível encontrar dois cenários: a) reduzir em 13,3% as perdas, sem impactar na aprovação; b) Produzir incremento de 23,9% na aprovação, sem aumentar a perda. Com a solução encontrada pela Neurotech, o ganho KS atingiu 54%, com aumento de 9,5 p.p.(pontos percentuais)

O caso permite estimar quão profundo será o impacto nas técnicas de modelagem para análises preditivas de concessão de crédito. Se até o momento as instituições financeiras se queixavam da falta de informação para desenvolverem políticas de diferenciação de taxas que promovessem maior justiça e um fomento mais saudável ao consumo, a partir deste tripé composto por Cadastro Positivo, Open Banking, Dados Alternativos isso muda definitivamente.

Com essa profusão de dados, sai na frente quem for mais eficiente em entender os cenários e desenvolver produtos e serviços adaptados para cada perfil de cliente. Tudo de forma rápida e coordenada.

Concessão de crédito digital e segura pelo Whatsapp: uma novidade Neurotech

Por isso, as empresas devem se preparar desde já para essa nova realidade que, mais cedo ou mais tarde, vai intensificar uma segmentação no atendimento. Com isso, cada vez mais, as soluções de prateleira serão, em perspectiva às possibilidades deste novo cenário, menos eficientes.

Para se ter uma ideia, em um caso de cobrança, em que o desafio foi maximizar estratégias de acionamento e efetivação de acordos, reduzindo custos e aumento recuperação, foi registrado ROI na ordem de 20 vezes. Para esse cliente, foram cruzadas mais de 15 mil variáveis da Neurolake e customizado o modelo C-Score (produto da Neurolake) baseado no alvo de realização de acordos.

Assim, cada vez mais os conectores de dados e fontes, além dos motores de decisão, demandarão organização para ter agilidade na construção e revisão de modelos. Com novos dados constantemente surgindo, somente uma plataforma integrada permitirá a modelagem adequada.

Leia também:

Pix, open banking, cadastro positivo e LGPD transformarão a análise de crédito em 2021

*Breno Costa é Diretor de Produtos e Sucesso do Cliente da Neurotech

Por Neurotech | 6 de novembro de 2020

Nunca antes produzimos tantos dados. Hoje, em 24 horas, geramos mais informações do que a humanidade produziu desde o seu início até o ano de 2003. E muito disso se deve à transformação digital. Estamos mais conectados e isso contribuiu para a maneira como nos comunicamos, consumimos, nos entretemos, fazemos nossas pesquisas diárias, estudamos e nos relacionamos. E cada um desses movimentos que fazemos diariamente com a ajuda da internet gera uma enorme quantidade de informações no meio digital, que podem ser armazenadas e estruturadas no Big Data.

Mas o mais interessante é que essas informações podem auxiliar a sua empresa, dos mais diferentes segmentos, na gestão de riscos. Ou seja, contribuindo com a tomada de decisões, reduzindo problemas, prevenindo prejuízos e otimizando resultados. Dados combinados com o conhecimento e a inteligência de gestores podem tornar o futuro mais previsível!

A grande jogada do Big Data é coletar e processar grande quantidade de dados, que podem ser analisados para obter insights sobre o que está acontecendo e o que pode acontecer. E é esse conhecimento obtido que possibilitará a tomada de decisões com mais qualidade e permitirá visualizar melhores oportunidades no mercado.

Seja qual for a necessidade, decisões estão sendo tomadas e serão cada vez mais necessárias utilizando métodos estatísticos e matemáticos. Esses métodos envolvem Inteligência Artificial e Machine Learning para prever comportamentos e descrever possíveis tendências em cenários de Big Data.

Em especial, na gestão de riscos, as análises em tempo real de distintas variáveis internas e do mercado contribuem para identificar padrões de comportamento, descobrir tendências, definir e corrigir estratégias de negócios, antecipar possíveis resultados e fazer recomendações.

Com dados relevantes fornecidos pelo Big Data, uma vasta gama de possibilidades se abre para a instituição na gestão de riscos. Uma delas é fazer a análise preditiva.

Na análise preditiva, as previsões são geradas do que poderá ocorrer no futuro a partir de uma decisão tomada. Estimar o risco de fraude em uma operação de crédito é um bom exemplo. Assim, a gestão de riscos torna-se mais eficiente.

É importante que gestores pensem sobre como analisar dados pode gerar valor para a própria empresa e seus consumidores. Assim, dentro de um ciclo virtuoso de quatro etapas, os dados podem ser colocados no centro do processo de decisão:

1 - Coleta de dados de várias fontes;

Entender a variedade e o volume dos dados internos, que bases estão disponíveis e em que sistemas estão armazenados, é o primeiro passo do processo. Devem ser considerados também os dados do mercado, de bases externas, e dados coletados da internet, em linha com a LGPD para usufruir da riqueza das informações. Cada fonte de dado deve ser coletada por plataformas de software ou aplicativos de acordo com seu tipo e formato.

2 - Integrar e organizar;

Nessa etapa, os tipos de dados devem ser integrados para viabilizar análises futuras, considerando o cruzamento da diversidade de fontes disponíveis. Os critérios de segurança e permissão quanto ao uso devem estar bem definidos e os dados devem ser representados em um formato (normalmente uma grande tabela) que facilite a criação das soluções de análise dos dados.

3 - Usar para criar soluções de apoio à decisão;

Em seguida, é preciso validar, limpar e enriquecer os dados para eliminar erros e incoerências, tratar dados incompletos e criar novas variáveis que capturam informações do problema. Os dados podem ser usados para criar modelos preditivos, prescritivos e descritivos com os algoritmos de Machine Learning. Aqui, gestores com conhecimento do negócio são fundamentais na construção das soluções.

4 - Acompanhar os resultados no negócio.

Por fim, as soluções precisam ser monitoradas para garantir aderência e resultados relevantes. Análises estatísticas com indicadores técnicos e financeiros, software de relatórios, dashboards e outras ferramentas se juntam para acompanhar as soluções implantadas.

O resultado dessas etapas permite que o gestor tenha vantagens, como saber o que o cliente deseja, localizar compradores, monitorar a concorrência e, claro, prever riscos para o negócio. Não basta armazenar dados. Eles devem ser aproveitados para gerar valor e isso depende de curadoria, de expertise na mineração e de ferramentas criadas com o propósito de tratar e extrair conhecimento dos dados. Dados limpos ou relevantes para uma empresa devem ser organizados para permitir análise. E isso exige esforço para aproveitar a riqueza dos dados.

Um movimento que abriu espaço para uma nova geração de profissionais, os cientistas de dados, que migraram de diversas áreas, mas com algumas características em comum: habilidades técnicas para resolver problemas complexos e a curiosidade necessária para explorar situações capazes de resolvê-los. Isso trouxe oportunidades para todo tipo de profissional. É janela para buscar as soluções em um mundo de possibilidades, onde tudo cabe.

Trata-se de uma área interdisciplinar, que avança com o Big Data e só faz sentido a partir da compreensão de dados diversos e suas possíveis aplicações na resolução de problemas. É dessa necessidade que surge o trabalho do cientista de dados. É ele que extrai o conhecimento necessário para detectar padrões e obter variáveis para possíveis tomadas de decisão.

Mas quem são esses profissionais e quais as oportunidades de mercado? E por que esta carreira se tornou tão badalada?

Muitos cientistas começaram suas carreiras em estatística ou análise de dados, mas, à medida que o Big Data começou a crescer e evoluir, esses papéis também evoluíram. Atualmente, Ciência de Dados envolve atuação direta em áreas como computação tradicional, matemática, estatística, engenharia, sociologia e política, entre outras.

O próprio meio acadêmico abriu espaço para esses profissionais justamente pela sua versatilidade, já que o trabalho engloba técnicas que passam pelo desenvolvimento da aprendizagem de máquina e aplicações como motores de busca até tradução automática e reconhecimento de voz.

Assim como a computação, Data Science pode ser aplicada a diferentes domínios do conhecimento e não restrita a uma única indústria, como a análise tradicional tende a ser. Enquanto o domínio da expertise é imperativa para identificar problemas específicos para determinada empresa, o entendimento e experiência em extrair conhecimento de diferentes domínios oferece um amplo escopo para insights de negócios.

Contudo, assim como acontece em várias profissões criadas nos últimos anos, muita gente não sabe dizer quais são as atribuições diárias de quem trabalha com Data Science. Pelo nome, é até possível entender que análise e organização de informações fazem parte da rotina, mas na prática é um aprofundamento detalhado capaz de captar as nuances de determinado assunto. Sendo assim, o trabalho em equipe é um requisito fundamental.

Por ser um campo que avança rapidamente, é uma carreira que exige capacidades diferentes dos profissionais que trabalham na área. Atualização e aprendizado permanentes estão dentro das características exigidas para quem pretende ingressar na carreira. Nos próximos anos, a demanda pelos cientistas de dados só tende a aumentar e o investimento em qualificação pode ser um diferencial também na hora de se posicionar no mercado.

Conteúdo bem completo que preparamos para você sobre Data Science!

E o que não deu tempo de responder na live, nossos dataninjas Joyce Sá, Marcio de Lucas e Renata Santos responderam aqui:

Por Breno Costa *

Após décadas de lamentações pela escassez de dados para realizar uma análise de risco de crédito mais precisa que pudesse viabilizar o desenvolvimento de políticas mais justas e adequadas a cada perfil de tomador, a indústria financeira já começou a experimentar exatamente a outra face desta moeda que é a abundância de informações. E estamos no começo!

Embora esta seja uma notícia positiva, resta a dúvida sobre a real capacidade das estruturas e estratégias atuais de análise de risco para lidar com esta profusão de possíveis insights. Fato é que ao passar dos meses em 2021 se formará uma verdadeira engrenagem fornecedora de informações.

Aliada aos chamados dados alternativos, instrumentos e legislações recém criadas como os pagamentos instantâneos (PIX), o Open Banking, o Cadastro Positivo e da Lei Geral de Proteção e Dados (LGPD), cada um ao seu modo, contribuirá para que as instituições financeiras, e até de outros mercados, saibam cada vez mais sobre os consumidores atuais e também sobre aqueles que atualmente são os chamados de ‘invisíveis’ por até então não terem mantido um relacionamento formal com bancos.

Os dados alternativos (ou dados não estruturados) já são uma realidade que muitos players testaram e implantaram. Para acessá-los, precisamos de uso intensivo de IA, Big Data e Machine Learning. São um forte aliado às informações tradicionais e melhoraram o conhecimento que temos que cada cliente ou indivíduo.

O PIX promete incluir milhões de pessoas cujo comportamento com o dinheiro é completamente desconhecido dos Bureaus e dos Sistemas de Crédito. Por sua vez o Open Banking oferecerá a possibilidade de compartilhamento de informações de uma maneira nunca realizada. Enquanto isso o Cadastro Positivo seguirá engordando seu banco de dados para ir além dos alertas sobre dívidas não pagas pelas pessoas.

Amarrando tudo isso, a LGPD garantirá a segurança de que não haverá abusos no uso destas informações.

Todo esse combo poderá contar com o suporte de tecnologias emergentes e disruptivas como Big Data, Machine Learning, Inteligência Artificial e outras para o desenvolvimento de modelagem para análises preditivas muito mais complexas e profundas do que as atuais.

A grande questão será como estruturar essa profusão de dados e abarcar todo o contingente de potenciais novos consumidores, antes fora do sistema bancário, de maneira adequada à estratégia de cada negócio.

A profusão de dados de diversas fontes exigirá uma nova estruturação de captação e análise. Quem for mais eficiente em aproveitar esta nova realidade para entender os cenários e desenvolver produtos e serviços adaptados para cada perfil de cliente, certamente levará vantagem sobre aqueles que apenas verão a enxurrada de informações passarem pelos seus bancos de dados de forma descoordenada.

Fato é que as empresas devem se preparar desde já para essa nova realidade que, mais cedo ou mais tarde, vai intensificar uma segmentação no atendimento, colocando um fim definitivo na exclusividade de decisão baseada nos produtos oferecidos pelos bureaus de crédito.

Em contrapartida, fica a torcida para que a soma entre maior volume de informações e análise mais qualificada resulte em menores taxas, maiores índices de concessão de crédito e, consequentemente, aumento do consumo que leva à elevação da produção e geração de empregos.

Um pacote que faz a roda da economia girar.

*Breno Costa é Diretor de Produtos e Sucesso do Cliente da Neurotech

D

As aplicações de Inteligência Artificial que se adequam ao seu negócio são inúmeras. Ao unir essa tecnologia aos seus processos de decisão você pode usá-la de diversas formas, melhorando a sua gestão e tomando decisões baseadas em fatos, e não apenas em intuição ou informações incompletas. Como resultado, você tem a chance de oferecer uma melhor experiência para os seus consumidores.

Se você deseja saber qual solução é a ideal para os desafios que a sua empresa enfrenta, conte com a Neurotech! Somos especialistas em Big Data e Inteligência Artificial e podemos ajudar você a se destacar no mercado.